LLM на вашем телефоне

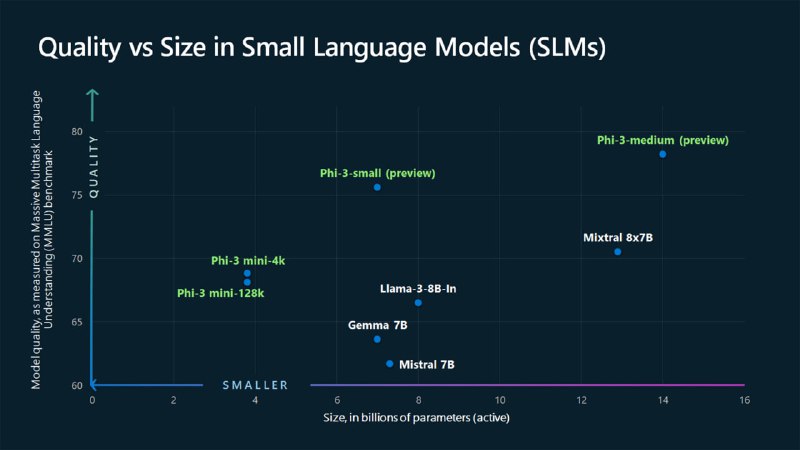

Microsoft выпустила серию LLM моделей Phi-3, которая включает три размера:

🟥 mini (3,8 млрд параметров, 69% на MMLU, 8.38 у MT-bench),

🟥 small (7 млрд параметров, 75% на MMLU, 8.7 у MT-bench)

🟥 medium (14 млрд параметров, 78% on MMLU, 8.9 у MT-bench).

Эти модели разработаны для эффективной работы как на мобильных устройствах, используя передовые наборы данных для достижения высокой производительности.

у phi-3-mini, обученной на 3,3 триллионах токенов, общая производительность конкурирует с такими моделями, как Mixtral 8x7B и GPT-3.5, несмотря на малый размер (требует всего ~2Гб оперативы, в то время, как тот же Mixtral 8x7B — ~22Гб !)

@Unlim_AI

Microsoft выпустила серию LLM моделей Phi-3, которая включает три размера:

Эти модели разработаны для эффективной работы как на мобильных устройствах, используя передовые наборы данных для достижения высокой производительности.

у phi-3-mini, обученной на 3,3 триллионах токенов, общая производительность конкурирует с такими моделями, как Mixtral 8x7B и GPT-3.5, несмотря на малый размер (требует всего ~2Гб оперативы, в то время, как тот же Mixtral 8x7B — ~22Гб !)

@Unlim_AI