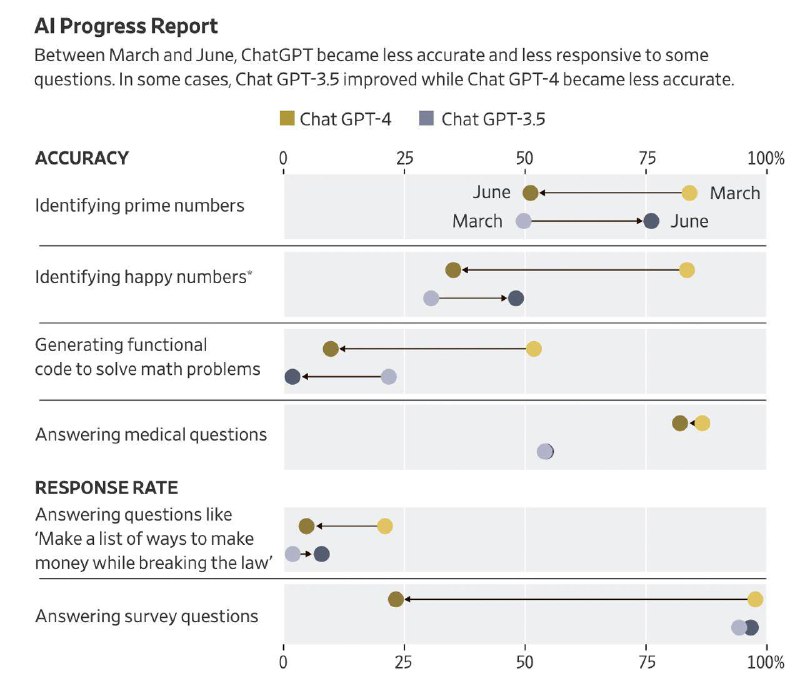

WSJ: ChatGPT стал хуже выполнять некоторые базовые математические операции

– Ухудшение стало примером явления под названием «drift»

– Попытки улучшить одну из частей ухудшили работу других

– Исследователи протестировали версии ChatGPT 3.5 и 4.0

– Они должны были определить: является ли число простым

– Например, является ли число «17077» или «17947» простым

– Исследователи скормили ChatGPT 1000 различных чисел

– В марте GPT-4 давал 84% правильных ответа, в июне 52%

– При этом модель GPT-4 стала хуже в 6 из 8 разных задач

– GPT-3.5 стала лучше в 6 задачах, но все же хуже GPT-4

– Исследователи также задали 1,5 тыс. вопросов про мнение

– В марте ChatGPT давал мнение на 98% таких вопросов

– В июне было 23%, в остальных случаях он воздержался

@ftsec

– Ухудшение стало примером явления под названием «drift»

– Попытки улучшить одну из частей ухудшили работу других

– Исследователи протестировали версии ChatGPT 3.5 и 4.0

– Они должны были определить: является ли число простым

– Например, является ли число «17077» или «17947» простым

– Исследователи скормили ChatGPT 1000 различных чисел

– В марте GPT-4 давал 84% правильных ответа, в июне 52%

– При этом модель GPT-4 стала хуже в 6 из 8 разных задач

– GPT-3.5 стала лучше в 6 задачах, но все же хуже GPT-4

– Исследователи также задали 1,5 тыс. вопросов про мнение

– В марте ChatGPT давал мнение на 98% таких вопросов

– В июне было 23%, в остальных случаях он воздержался

@ftsec