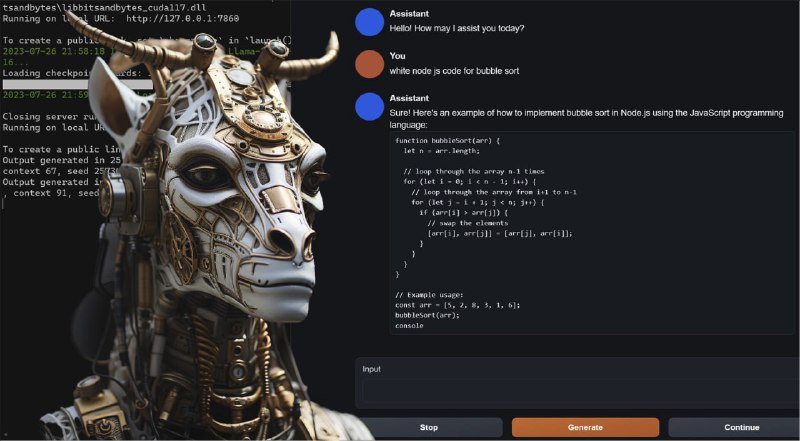

Попробовал вчера вечером эту вашу Лламу.

Отличная возможность локально запускать неплохие модели.

Удалось поднять 13B на ноутбуке с GeForce 3080/16VRAM, но этого понятное дело мало, поэтому на тестах получилось

13B: 0.4 токена в секунду для 16бит,

7B: 8т/с для 8 бит и 12-15т/с для 4 бит.

Инструкция и модель тут:

https://huggingface.co/TheBloke/Llama-2-13B-fp16

Отличная возможность локально запускать неплохие модели.

Удалось поднять 13B на ноутбуке с GeForce 3080/16VRAM, но этого понятное дело мало, поэтому на тестах получилось

13B: 0.4 токена в секунду для 16бит,

7B: 8т/с для 8 бит и 12-15т/с для 4 бит.

Инструкция и модель тут:

https://huggingface.co/TheBloke/Llama-2-13B-fp16