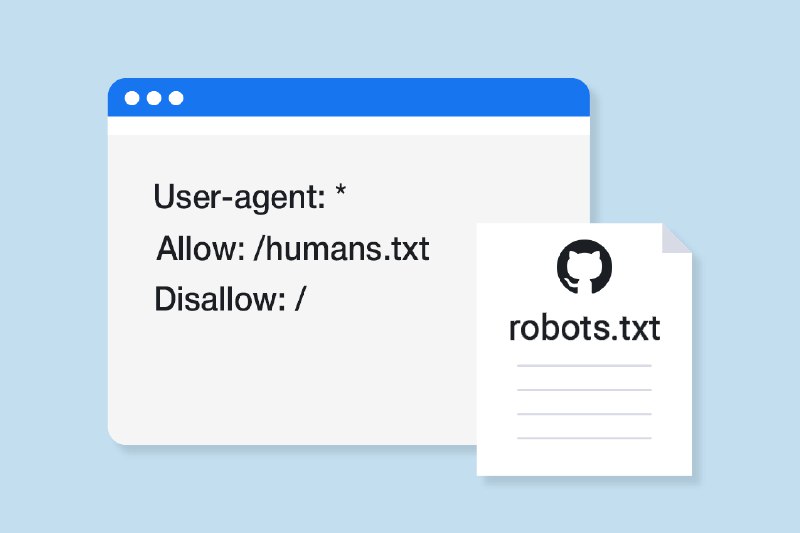

Помните про файл robots.txt, который позволяет разработчикам исключать определённые страницы сайта из поисковой выдачи?

Так вот, у GitHub в этом файле есть одна интересная деталь. В секцию Disallow добавлен единственный пользовательский репозиторий — «/ekansa/Open-Context-Data»: https://github.com/robots.txt

В твиттере создатель этого репозитория рассказал, что однажды он решил использовать гитхаб в качестве публичного хранилища большого количества XML-файлов своего проекта OpenContext: https://twitter.com/ekansa/status/1137052076062650368

В итоге в этот репозиторий полились реки трафика из поиска, что, собственно, и не понравилось гитхабу. Простейшим способом решить эту проблему стало добавление всего репозитория в robots.txt.

А ещё в конце этого файла есть пасхалочка для людей, которые в душе поисковики.

Так вот, у GitHub в этом файле есть одна интересная деталь. В секцию Disallow добавлен единственный пользовательский репозиторий — «/ekansa/Open-Context-Data»: https://github.com/robots.txt

В твиттере создатель этого репозитория рассказал, что однажды он решил использовать гитхаб в качестве публичного хранилища большого количества XML-файлов своего проекта OpenContext: https://twitter.com/ekansa/status/1137052076062650368

В итоге в этот репозиторий полились реки трафика из поиска, что, собственно, и не понравилось гитхабу. Простейшим способом решить эту проблему стало добавление всего репозитория в robots.txt.

А ещё в конце этого файла есть пасхалочка для людей, которые в душе поисковики.