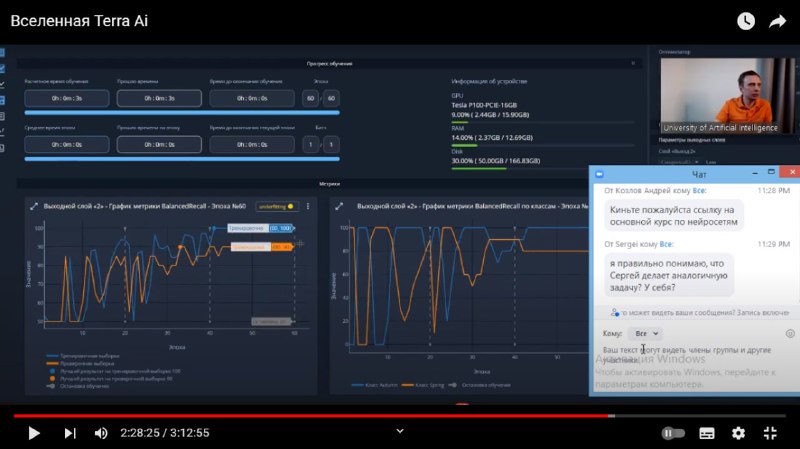

Первым объяснением этого паранормального явления, которое пришло мне в голову, было, что на самом деле никакая нейросеть не обучалась, а графики сгенерировали с потолка. Но затем я повнимательнее всмотрелась в название метрики: над графиками написано не "Accuracy", как я автоматически подумала, услышав о "точности классификации", а "Balanced Recall".

Recall - это метрика, равная количеству примеров, для которых _правильно_ предсказана метка 1 (True Positive), разделенных на количество примеров, имеющих истинную метку 1 (True Positive + False Negative).

Recall равен 1, если модель присваивает всем примерам метку 1. Отсюда следующая гипотеза:

Возможно, выход нейросети Дмитрия неправильно отнормирован, и в процессе "обучения" (если это можно так назвать) сеть учится выдавать числа, близкие к 1, для обоих классов, а затем для каждого класса в отдельности считается Recall, также равный 1 или чуть меньше. На графиках слева мы видим взвешенное среднее арифметическое от обоих Recallов, поэтому он и зовется Balanced.

Recall - это метрика, равная количеству примеров, для которых _правильно_ предсказана метка 1 (True Positive), разделенных на количество примеров, имеющих истинную метку 1 (True Positive + False Negative).

Recall равен 1, если модель присваивает всем примерам метку 1. Отсюда следующая гипотеза:

Возможно, выход нейросети Дмитрия неправильно отнормирован, и в процессе "обучения" (если это можно так назвать) сеть учится выдавать числа, близкие к 1, для обоих классов, а затем для каждого класса в отдельности считается Recall, также равный 1 или чуть меньше. На графиках слева мы видим взвешенное среднее арифметическое от обоих Recallов, поэтому он и зовется Balanced.