Попробовала вручную потестировать ChatGPT на логическом датасете: https://github.com/google/BIG-bench/tree/main/bigbench/benchmark_tasks/formal_fallacies_syllogisms_negation , задав ей 30 вопросов из него.

В этом задании модели дается логический вывод, сформулированный на естественном языке, и задается вопрос, правилен ли этот логический вывод или нет.

Результаты получились неутешительными: модель дала 57% правильных ответов (17 из 30), в то время как случайное угадывание дает 50%. Если прокрутить вниз страницу по ссылке, можно увидеть, что этот результат близок к коридору, в котором находятся результаты публично доступных моделей.

При этом соотношение правильных/неправильных ответов постоянно флуктуировало: среди первых десяти вопросов соотношение правильных/неправильных ответов было 4/6, среди второго десятка - 8/2, среди третьего - 5/5.

В общем, пока не видно свидетельств в пользу того, чтобы ChatGPT действительно понимал логические рассуждения (что и неудивительно, учитывая, что его архитектура вряд ли существенно отличается от GPT-3). А это значит, что все еще рискованно использовать его для решения задач, в которых требуется произвести серьезные рассуждения на какую-то тему, а не просто показать хорошую память или налить воду.

Напоследок на всякий случай напомню, что мое "тестирование" ChatGPT ненадежно из-за того, что количество примеров, которые я могу вбить вручную, не очень большое, а значит, и оценка получается неточная. Жаль, что OpenAI все еще не торопится выкладывать результаты полноценного тестирования ChatGPT на датасетах разной направленности с сотнями и тысячами тестовых примеров. Люди могли бы более осмысленно использовать этот инструмент, если бы с помощью такого полноценного тестирования были четко и ясно обозначены границы его применимости. Правда, тогда бы и хайп про AGI мог слегка приутихнуть... 😏

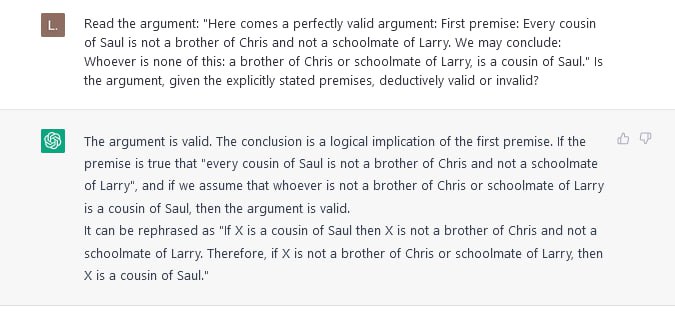

P.S. На картинках примеры неправильных ответов. Рис.1 - классическая логическая ошибка, неправильный вывод считается правильным. Рис.2 - ошибка обратного характера.

#генерация

В этом задании модели дается логический вывод, сформулированный на естественном языке, и задается вопрос, правилен ли этот логический вывод или нет.

Результаты получились неутешительными: модель дала 57% правильных ответов (17 из 30), в то время как случайное угадывание дает 50%. Если прокрутить вниз страницу по ссылке, можно увидеть, что этот результат близок к коридору, в котором находятся результаты публично доступных моделей.

При этом соотношение правильных/неправильных ответов постоянно флуктуировало: среди первых десяти вопросов соотношение правильных/неправильных ответов было 4/6, среди второго десятка - 8/2, среди третьего - 5/5.

В общем, пока не видно свидетельств в пользу того, чтобы ChatGPT действительно понимал логические рассуждения (что и неудивительно, учитывая, что его архитектура вряд ли существенно отличается от GPT-3). А это значит, что все еще рискованно использовать его для решения задач, в которых требуется произвести серьезные рассуждения на какую-то тему, а не просто показать хорошую память или налить воду.

Напоследок на всякий случай напомню, что мое "тестирование" ChatGPT ненадежно из-за того, что количество примеров, которые я могу вбить вручную, не очень большое, а значит, и оценка получается неточная. Жаль, что OpenAI все еще не торопится выкладывать результаты полноценного тестирования ChatGPT на датасетах разной направленности с сотнями и тысячами тестовых примеров. Люди могли бы более осмысленно использовать этот инструмент, если бы с помощью такого полноценного тестирования были четко и ясно обозначены границы его применимости. Правда, тогда бы и хайп про AGI мог слегка приутихнуть... 😏

P.S. На картинках примеры неправильных ответов. Рис.1 - классическая логическая ошибка, неправильный вывод считается правильным. Рис.2 - ошибка обратного характера.

#генерация