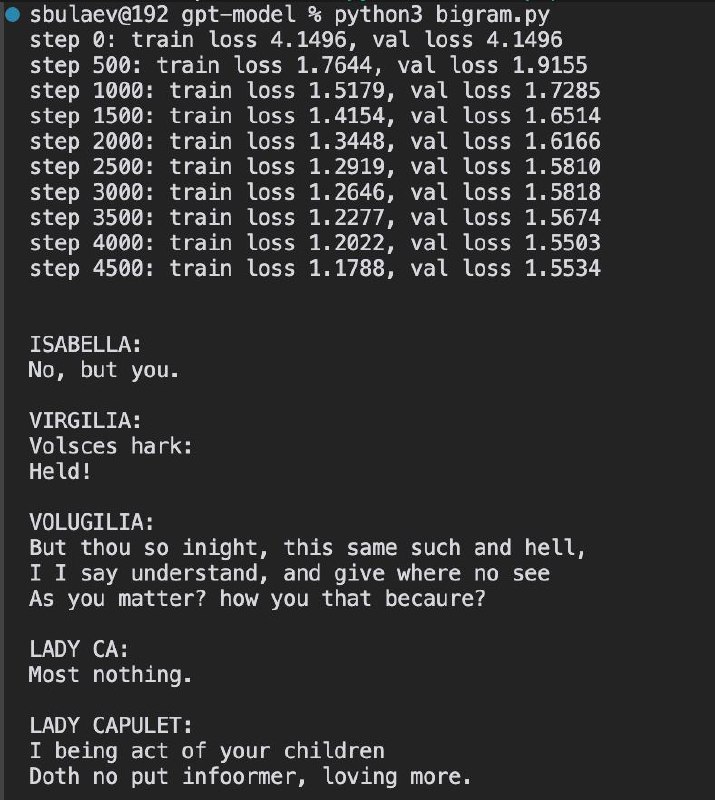

Благодаря тому, что Андрей Карпаты выпустил сегодня видео о том, как воссоздать GPT-2 с нуля, я натолкнулся на его другую, более простую запись, сделанную год назад. После трёх часов просмотра, пауз, задавания вопросов и ковыряния, вспоминания, что такое нижнетреугольная матрица и как их умножают, до меня наконец окончательно дошло, как работают трансформеры. Только теперь понял, что такое тренировка модели и как выглядит натренированная модель. И самое главное — откуда берутся все эти вектора (embeddings). Не прошло и двух лет, как я их использую. Оказалось, это вполне можно понять. Но пока как быстро и просто объяснить — не придумал. Как придумаю — расскажу.