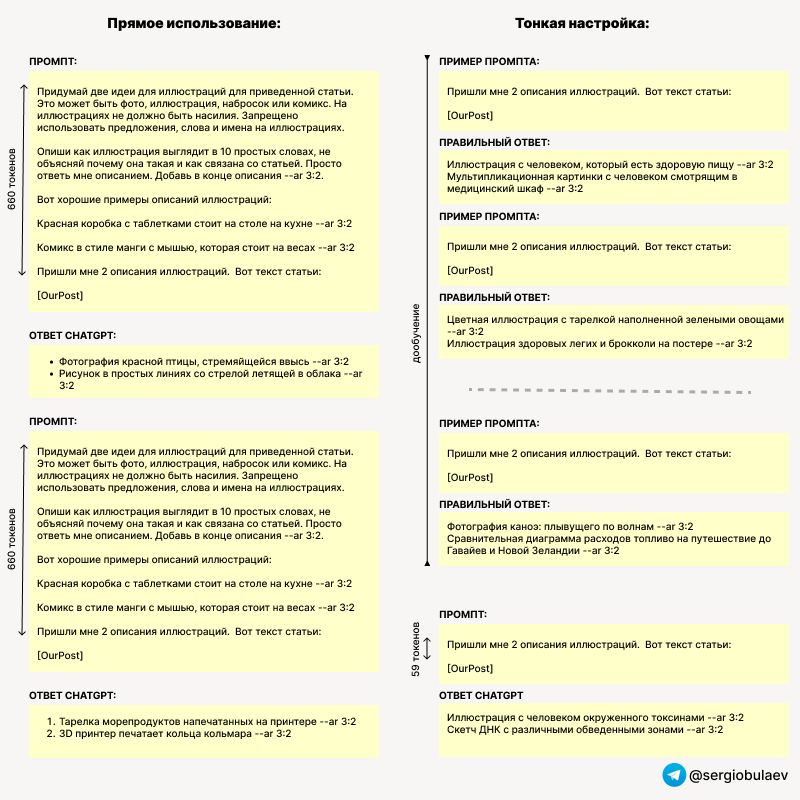

Как происходит тонкая настройка? Мы создаем набор примеров промптов и ожидаемых ответов на них. Закачиваем и "компилируем", далее можем использовать дообученую модель точно так же как обычную. Тратим деньги на "дообучени", но экономим на дальнейшем использовании. Сейчас это можно сделать через API, но скоро ожидается UI интерфейс.

Я, например, часто прошу модель отвечать мне в JSON формате, и вижу, на сколько вариативность ответов высока. Предоставление конкретных примеров ответов в промпте (повышая его размер) улучшает стабильность, хотя и не радикально. Чем больше примеров, тем выше стоимость. Другой вариант использования лично для меня - генерация запросов к MidJourney - обязательно создам себе модель заточенную только на это.

Я, например, часто прошу модель отвечать мне в JSON формате, и вижу, на сколько вариативность ответов высока. Предоставление конкретных примеров ответов в промпте (повышая его размер) улучшает стабильность, хотя и не радикально. Чем больше примеров, тем выше стоимость. Другой вариант использования лично для меня - генерация запросов к MidJourney - обязательно создам себе модель заточенную только на это.