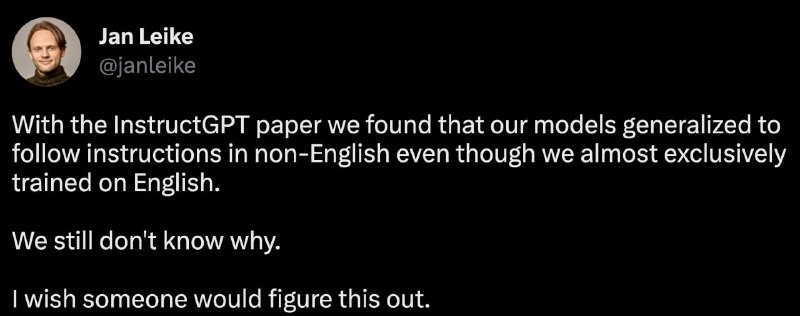

Принёс вам твит Лида исследовательской команды Alignment в OpenAI. ChatGPT/InstructGPT - это их рук дело; обучение модели по обратной связи от людей есть суть Alignment'a ("выравнивания" нейронок с человеческим восприятием и пониманием).

Он говорит, что полученные модели очень хорошо обобщили свои новые знания (тренировка на инструкциях, с фидбеком) на другие языки, на которых тюнинг не производился. Из оригинальной статьи:

> Empirically, around 96% of our dataset (110k datapoints) is classified as English, although we estimate that the actual fraction may be 99% or higher, due to classifier inaccuracies.

И...группа исследователей до сих пор не понимает почему 🤷♂️

Это очень схоже с тем, как учится человек - если вы изучаете новый язык, то не забываете свой багаж знаний. Вы можете концепты, изученные в школе на родном языке, воспроизводить и трансформировать (развивать идеи, рассуждать) в новой обстановке на другом.

Понятно, что эти знания в модели уже были в каком-то виде, так как оригинальная GPT3 обучалась на данных с примесью других языков, однако именно тюнинг из фидбека позволил "разблокировать" эти знания, и использовать для более точных и качественных ответом. Удивительное свойство.

Ждём, пока GPT-4 придумает свой язык, который мы понять не сможем😭

UPD: смысл в том, что это неочевидное свойство, что модель Out-of-distribution примеры тоже начинает лучше обрабатывать. Это приводит к вопросу: а какие еще свойства начинают проявляться? Что работает лучше, чем было?

Он говорит, что полученные модели очень хорошо обобщили свои новые знания (тренировка на инструкциях, с фидбеком) на другие языки, на которых тюнинг не производился. Из оригинальной статьи:

> Empirically, around 96% of our dataset (110k datapoints) is classified as English, although we estimate that the actual fraction may be 99% or higher, due to classifier inaccuracies.

И...группа исследователей до сих пор не понимает почему 🤷♂️

Это очень схоже с тем, как учится человек - если вы изучаете новый язык, то не забываете свой багаж знаний. Вы можете концепты, изученные в школе на родном языке, воспроизводить и трансформировать (развивать идеи, рассуждать) в новой обстановке на другом.

Понятно, что эти знания в модели уже были в каком-то виде, так как оригинальная GPT3 обучалась на данных с примесью других языков, однако именно тюнинг из фидбека позволил "разблокировать" эти знания, и использовать для более точных и качественных ответом. Удивительное свойство.

Ждём, пока GPT-4 придумает свой язык, который мы понять не сможем

UPD: смысл в том, что это неочевидное свойство, что модель Out-of-distribution примеры тоже начинает лучше обрабатывать. Это приводит к вопросу: а какие еще свойства начинают проявляться? Что работает лучше, чем было?