RL + NLP = ❤️

Статейка "Describe, Explain, Plan and Select: Interactive Planning with Large Language Models Enables Open-World Multi-Task Agents" рассказывает о том, как прикрепить большие языковые модели (LLM) к обучению агентов в сложных средах.

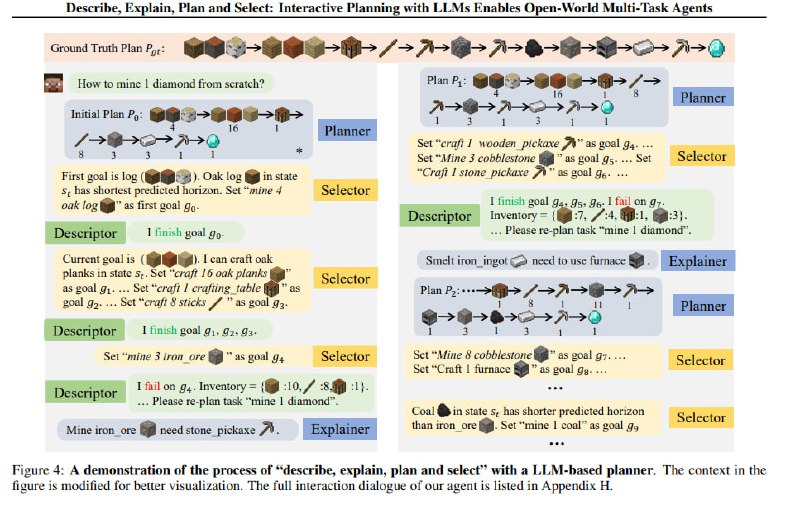

Картинка вкратце описывает суть происходящего:

1) LLM генерирует план, который должен быть выполнен, чтобы добиться награды

2) Selector выбирает, что нужно сделать сейчас, передает это в агента на исполнение

3) Агент сообщает LLMке в текстовом виде, каких успехов он добился, а чего сделать не смог (прям как я маме😂 )

4) формируется новый план, и пункты 1-3 повторяются итеративно

И всё это происходит в виде диалога с чатботом!

Ну и это конечно же бустит перформанс: Our experiments mark the milestone of the first multi-task agent that can robustly accomplish 70+ Minecraft tasks and nearly doubles the overall performances

Жду, когда больше техник из NLP для работы с LLM (вроде этой) придут в другие области.

Код будет тут, но пока его нет.

Статейка "Describe, Explain, Plan and Select: Interactive Planning with Large Language Models Enables Open-World Multi-Task Agents" рассказывает о том, как прикрепить большие языковые модели (LLM) к обучению агентов в сложных средах.

Картинка вкратце описывает суть происходящего:

1) LLM генерирует план, который должен быть выполнен, чтобы добиться награды

2) Selector выбирает, что нужно сделать сейчас, передает это в агента на исполнение

3) Агент сообщает LLMке в текстовом виде, каких успехов он добился, а чего сделать не смог (прям как я маме

4) формируется новый план, и пункты 1-3 повторяются итеративно

И всё это происходит в виде диалога с чатботом!

Ну и это конечно же бустит перформанс: Our experiments mark the milestone of the first multi-task agent that can robustly accomplish 70+ Minecraft tasks and nearly doubles the overall performances

Жду, когда больше техник из NLP для работы с LLM (вроде этой) придут в другие области.

Код будет тут, но пока его нет.