Посмотрел TED Talk от Президента OpenAI, Greg Brockman.

В нём Greg рассказывает про то, насколько языковая модель становится более способной, если к ней прикрутить плагины (внешние модели и/или скрипты, с которыми GPT может "переписываться"). Это частично отсылает нас к основной причине, которую я упоминал на стриме с Валерой (появилась запись, кстати), почему языковые модели это умнО. Потому что они могут коммуницировать между собой также, как это делают люди, и выполнять разные роли, при этом программировать их на каком-то конкретном языке, отличном от английского, не нужно.

В общем, если хочется посмотреть демку - приглашаю к ознакомлению. Но упомянул я видео не поэтому, что хотел приплести видос с Валерой - а потому что среди прочего у Greg спросили, какие возможности модели его поразили.

Если вы помните, в статье про ChatGPT я писал, что GPT-3 научилась в математику, но только на уровне сложения-умножения 2-3 значных чисел. Там можно спекулировать, мол, все такие пары встречались в трейне, модель просто их выучила!

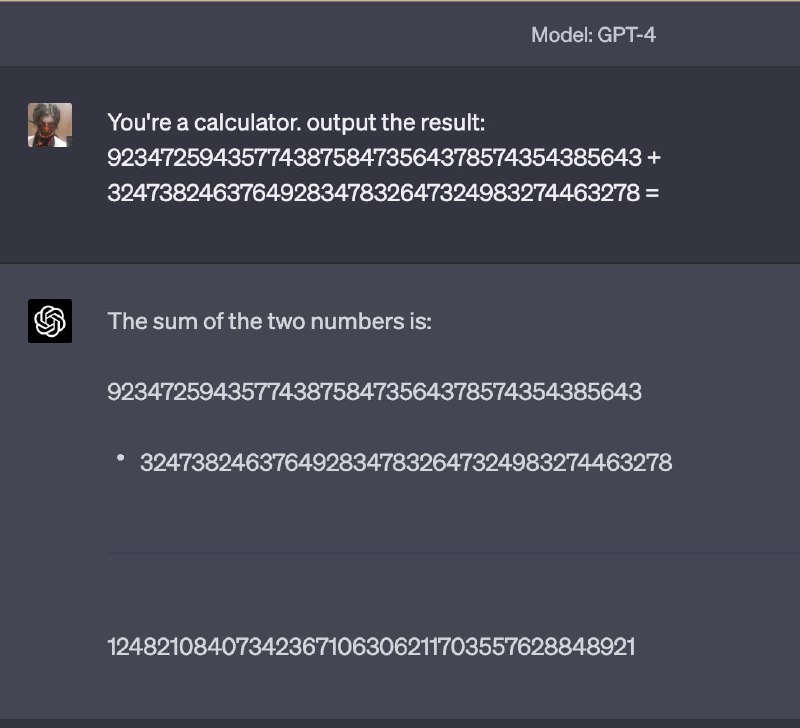

Ну так вот, Greg рассказал - а я проверил - что модель может складывать спокойно даже 40-значные числа, потому что она поняла процесс познакового сложения. При этом если дать одно 40 и одно 35 значное число - магии не произойдет. Числа, которые вводил я - полностью случайные, просто руками по клаве повозил. Уверен на 100%, что комбинация уникальная. Пример решён верно, перепроверил в Python. Оговорюсь, что перенос строки в промпте я не делал, это из-за ширины текстового окна так кажется, то есть даже форматирования простейшего нет.

P.S.: а ещё Greg поделился, что при запуске GPT-3 они боялись, что люди начнут генерировать дезинформацию, а те...начали генерировать спам про виагру (таблетки) ахаххахаха люди такие люди...

В нём Greg рассказывает про то, насколько языковая модель становится более способной, если к ней прикрутить плагины (внешние модели и/или скрипты, с которыми GPT может "переписываться"). Это частично отсылает нас к основной причине, которую я упоминал на стриме с Валерой (появилась запись, кстати), почему языковые модели это умнО. Потому что они могут коммуницировать между собой также, как это делают люди, и выполнять разные роли, при этом программировать их на каком-то конкретном языке, отличном от английского, не нужно.

В общем, если хочется посмотреть демку - приглашаю к ознакомлению. Но упомянул я видео не поэтому, что хотел приплести видос с Валерой - а потому что среди прочего у Greg спросили, какие возможности модели его поразили.

Если вы помните, в статье про ChatGPT я писал, что GPT-3 научилась в математику, но только на уровне сложения-умножения 2-3 значных чисел. Там можно спекулировать, мол, все такие пары встречались в трейне, модель просто их выучила!

Ну так вот, Greg рассказал - а я проверил - что модель может складывать спокойно даже 40-значные числа, потому что она поняла процесс познакового сложения. При этом если дать одно 40 и одно 35 значное число - магии не произойдет. Числа, которые вводил я - полностью случайные, просто руками по клаве повозил. Уверен на 100%, что комбинация уникальная. Пример решён верно, перепроверил в Python. Оговорюсь, что перенос строки в промпте я не делал, это из-за ширины текстового окна так кажется, то есть даже форматирования простейшего нет.

P.S.: а ещё Greg поделился, что при запуске GPT-3 они боялись, что люди начнут генерировать дезинформацию, а те...начали генерировать спам про виагру (таблетки) ахаххахаха люди такие люди...