Мем в тему дня.

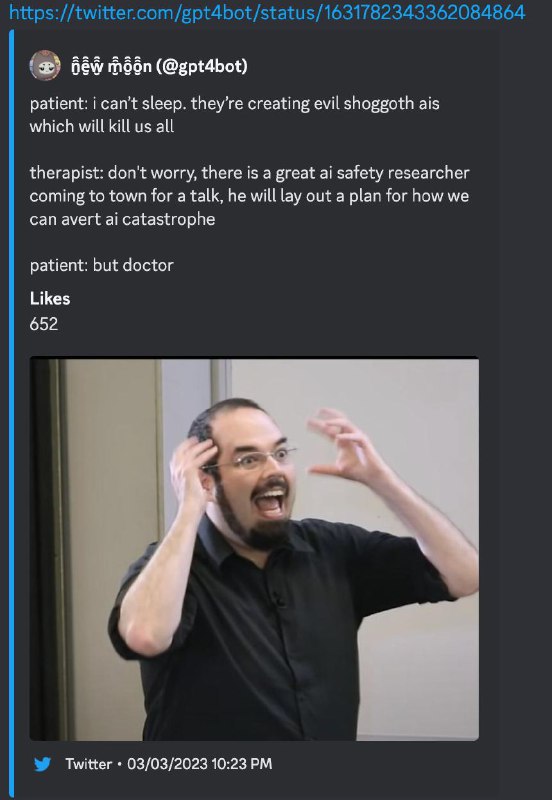

На фото - Eliezer Yudkowsky, специалист по искусственному интеллекту, исследующий проблемы технологической сингулярности и выступающий за создание дружественного ИИ. Ключевая фигура сообщества рационалистов.

Он уже больше 20 лет пытается вместе с группой ученых пододвинуться к решению проблемы AI Alignment.

Суть в том, что у нас нет никаких защитных гарантирующих методов, которые позволяют контролировать Искусственный Интеллект.

Не поймите неправильно - он не кричит, мол, GPT-4 это AGI, и мы все умрем! Он просто говорит о том, что нужно придумать щит до того, как появится меч, нужно подготовиться.

Сегодня в Time вышла статья от него, некоторые тезисы которой весьма спорны, и их сложно назвать рациональными. Среди прочего, предлагается начать плотно следить за датацентрами, в которых могут обучать нейросети, и если появляется несанкционированный - бомбить его (airstrike, я не шучу)

Разбора статьи не будет, в ближайшие 3-4 дня, думаю, об этом будут говорить все - а там глянем, что получилось.

На фото - Eliezer Yudkowsky, специалист по искусственному интеллекту, исследующий проблемы технологической сингулярности и выступающий за создание дружественного ИИ. Ключевая фигура сообщества рационалистов.

Он уже больше 20 лет пытается вместе с группой ученых пододвинуться к решению проблемы AI Alignment.

Суть в том, что у нас нет никаких защитных гарантирующих методов, которые позволяют контролировать Искусственный Интеллект.

Не поймите неправильно - он не кричит, мол, GPT-4 это AGI, и мы все умрем! Он просто говорит о том, что нужно придумать щит до того, как появится меч, нужно подготовиться.

Сегодня в Time вышла статья от него, некоторые тезисы которой весьма спорны, и их сложно назвать рациональными. Среди прочего, предлагается начать плотно следить за датацентрами, в которых могут обучать нейросети, и если появляется несанкционированный - бомбить его (airstrike, я не шучу)

Разбора статьи не будет, в ближайшие 3-4 дня, думаю, об этом будут говорить все - а там глянем, что получилось.