Что там все хайпят? LLAMA? А может быть лучше...ALPACA?

TLDR:

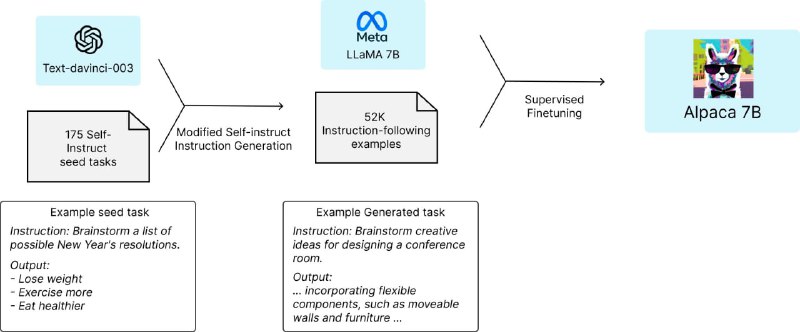

- исследователи Стэнфорда взяли утекшую LLAMA-7B c торента

- вспомнили про статью Self-Instruct, которая описывает, как заставить большую умную модель генерить инструкции для дообучения самой себя (звучит как-то...по ИИ-шески?)

- сгенерили 52к инструкций с помощью доступной по API модели GPT-3.5 (и это еще не ChatGPT!). Вышло меньше $500 на всё про всё

- дообучили LLAMA за 3 часа на 8xA100 (<$100 в облаке стоит, доступно каждому)

- сравнили с помощью слепого теста результаты генерации ответов на запросы полученной маленькой моделькой и оригинальной GPT-3.5

И получили сравнимый результат, 90 голосов против 89 за GPT-3.5. По сути с помощью $600, смекалкии чьей-то матери ребята "дистиллировали" закрытую модель OpenAI в свою локальную LLMку поменьше, хех (на некотором пуле задач и на английском языке). Можно ставить клеймо "СЛИТО".

Ссылка на демо: тык

Датасет демонстраций лежит на гите проекта: тык (кода тюнинга пока нет, ребята ждут аппрува PR от 🤗)

TLDR:

- исследователи Стэнфорда взяли утекшую LLAMA-7B c торента

- вспомнили про статью Self-Instruct, которая описывает, как заставить большую умную модель генерить инструкции для дообучения самой себя (звучит как-то...по ИИ-шески?)

- сгенерили 52к инструкций с помощью доступной по API модели GPT-3.5 (и это еще не ChatGPT!). Вышло меньше $500 на всё про всё

- дообучили LLAMA за 3 часа на 8xA100 (<$100 в облаке стоит, доступно каждому)

- сравнили с помощью слепого теста результаты генерации ответов на запросы полученной маленькой моделькой и оригинальной GPT-3.5

И получили сравнимый результат, 90 голосов против 89 за GPT-3.5. По сути с помощью $600, смекалки

Ссылка на демо: тык

Датасет демонстраций лежит на гите проекта: тык (кода тюнинга пока нет, ребята ждут аппрува PR от 🤗)