🚀 @SBERLOGASCI webinar on data science:

👨🔬 Сергей Лыткин (к.ф.-м.н.) "Введение в Reinforcement Learning методы на графах»

⌚️ Пятница 26 июля, 18.00 (по Москве)

Add to Google Calendar

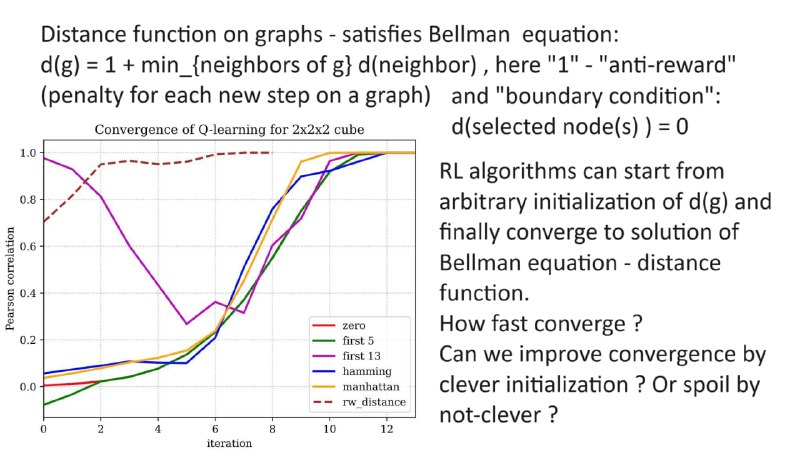

Будет рассказано применение методов RL к задачам теории графов. Дистанция на графе (до выделенной вершины или множества вершин) - удовлетворяет очень простому варианту уравнения Беллмана d(g) = 1 + min_{neigbours of g} d(neigbour) . Тем самым методы RL дают возможность искать решения уравнения Беллмана, а значит в частности находить метрику на графе, стартуя с произвольной инициализации. Как быстро будут сходиться алгоритмы RL ? Можно ли улучшить сходимость сделав правильную инициализацию ? Эти вопросы будут рассмотрены в докладе, ответы на них не так очевидны.

Будут рассмотрены примеры графа состояний (Кэли) маленького кубика Рубика размера 2×2×2 ( больше 3 миллионов состояний). Данный граф достаточно мал, для того чтобы было удобно и быстро проводить эксперименты, но уже нетривиален и можно видеть общие феномены.

Более общо методы Deep-Q-learning - нейронные сети совмещенные c RL позволяют работать с графами сверх больших размеров - 10^100. По аналогии с работами, где обучение с подкреплением с успехом применяется для нахождения оптимальных решений в играх с очень большим числом состояний, таких как шахматы или го (вспомним AlphaGo, AlphaZero, MuZero).

Notebooks: https://www.kaggle.com/code/fedmug/bellman-rc2

Notebooks: https://www.kaggle.com/code/fedmug/bellman-convergence-for-rc2

(Апвоуты - приветствуются ! )

Приходите на доклад ! А, также, если Вам интересно машинное обучение и/или математика - приглашаем Вас принять участие в проекте по применению методов МЛ/RL к теории групп/графов Кэли - напишите @alexander_v_c - если хотите принять участие.

Zoom link will be in @sberlogabig just before start. Video records: https://www.youtube.com/c/SciBerloga - subscribe !

👨🔬 Сергей Лыткин (к.ф.-м.н.) "Введение в Reinforcement Learning методы на графах»

⌚️ Пятница 26 июля, 18.00 (по Москве)

Add to Google Calendar

Будет рассказано применение методов RL к задачам теории графов. Дистанция на графе (до выделенной вершины или множества вершин) - удовлетворяет очень простому варианту уравнения Беллмана d(g) = 1 + min_{neigbours of g} d(neigbour) . Тем самым методы RL дают возможность искать решения уравнения Беллмана, а значит в частности находить метрику на графе, стартуя с произвольной инициализации. Как быстро будут сходиться алгоритмы RL ? Можно ли улучшить сходимость сделав правильную инициализацию ? Эти вопросы будут рассмотрены в докладе, ответы на них не так очевидны.

Будут рассмотрены примеры графа состояний (Кэли) маленького кубика Рубика размера 2×2×2 ( больше 3 миллионов состояний). Данный граф достаточно мал, для того чтобы было удобно и быстро проводить эксперименты, но уже нетривиален и можно видеть общие феномены.

Более общо методы Deep-Q-learning - нейронные сети совмещенные c RL позволяют работать с графами сверх больших размеров - 10^100. По аналогии с работами, где обучение с подкреплением с успехом применяется для нахождения оптимальных решений в играх с очень большим числом состояний, таких как шахматы или го (вспомним AlphaGo, AlphaZero, MuZero).

Notebooks: https://www.kaggle.com/code/fedmug/bellman-rc2

Notebooks: https://www.kaggle.com/code/fedmug/bellman-convergence-for-rc2

(Апвоуты - приветствуются ! )

Приходите на доклад ! А, также, если Вам интересно машинное обучение и/или математика - приглашаем Вас принять участие в проекте по применению методов МЛ/RL к теории групп/графов Кэли - напишите @alexander_v_c - если хотите принять участие.

Zoom link will be in @sberlogabig just before start. Video records: https://www.youtube.com/c/SciBerloga - subscribe !