Опять что-то дипмаинды наресерчили (им платят за это?)

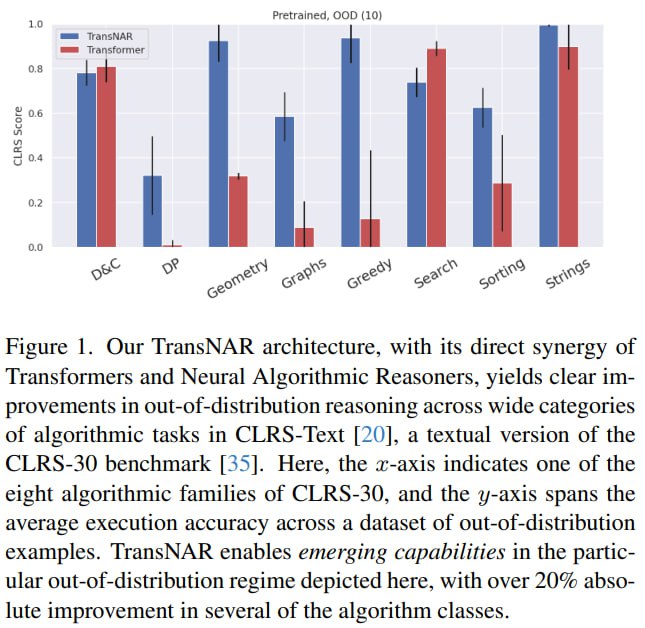

Хотят улучшать трансформеры на графовых задачках описанных текстом и сделали TransNAR архитектуру, которая вроде как хороша in out-of-distribution reasoning.

Только нам нужно иметь текстовую задачку на вход трансформера и граф на вход NAR.

По сути трансформер + графовые нейроночки. Такая графовая нейронка - это neural algorithmic reasoner (NAR), про который написано в статье DeepMind в 2021. Такая штука комбинирует натуральный вход + абстрактный вход (нейронок) для решения какой-то задачи. В статье ниже можно посмотреть идею на примере алгоритма Дейкстры.

Neural Algorithmic Reasoning

https://arxiv.org/abs/2105.02761

В данном случае natural input это текстовое описание задачи + соответствующий граф (abstract input), на выходе текст с решением. При этом графовая нейронка претрейнена на множестве алгоритмических задачек. Тренировались на маленьких задачках а тестились на больших.

Трансформер тоже претрейнен, на MassiveText.

Во время forward pass трансформер получает доступ к ембедингам из NAR через cross-attention. queries идут из токенов, а keys and values из NAR.

Так понял.

В общем если подобное интересует, то статью читаем

Transformers meet Neural Algorithmic Reasoners

https://arxiv.org/abs/2406.09308

тот самый датасет с графами, из которого получили текстовую версию и на ней тестились

https://github.com/google-deepmind/clrs

Хотят улучшать трансформеры на графовых задачках описанных текстом и сделали TransNAR архитектуру, которая вроде как хороша in out-of-distribution reasoning.

Только нам нужно иметь текстовую задачку на вход трансформера и граф на вход NAR.

По сути трансформер + графовые нейроночки. Такая графовая нейронка - это neural algorithmic reasoner (NAR), про который написано в статье DeepMind в 2021. Такая штука комбинирует натуральный вход + абстрактный вход (нейронок) для решения какой-то задачи. В статье ниже можно посмотреть идею на примере алгоритма Дейкстры.

Neural Algorithmic Reasoning

https://arxiv.org/abs/2105.02761

В данном случае natural input это текстовое описание задачи + соответствующий граф (abstract input), на выходе текст с решением. При этом графовая нейронка претрейнена на множестве алгоритмических задачек. Тренировались на маленьких задачках а тестились на больших.

Трансформер тоже претрейнен, на MassiveText.

Во время forward pass трансформер получает доступ к ембедингам из NAR через cross-attention. queries идут из токенов, а keys and values из NAR.

Так понял.

В общем если подобное интересует, то статью читаем

Transformers meet Neural Algorithmic Reasoners

https://arxiv.org/abs/2406.09308

тот самый датасет с графами, из которого получили текстовую версию и на ней тестились

https://github.com/google-deepmind/clrs