Наш дорогой друг и основатель Offsec ML Playbook - Adrian Wood. Недавно побывал на конференции BlackHat Asia 2024. На конференции он со своей коллегой Mary Walker - представили доклад, который называется "Confused Learning: Supply Chain Attacks through Machine Learning Models".

Я ознакомился с этим докладом. В докладе он представил ещё один способ выполнения вредоносного кода через модель, используя Keras Lambda layers. Раньше, он уже писал исследование на эту тему.(почитайте, это довольно интересный метод).

Какой метод был описан в докладе ? Если очень доступно, то в презентации был описан метод, когда злоумышленник, может хранить вредоносный код в lambda_layers, который расположен в файле keras_metadata.pb - этот файл получается в результате сериализации с использованием protobuf, и в дальнейшем он используется для работы модели.

Самое интересное. Они провели анализ 3000 моделей на huggingface, и нашли из них 24, которые содержали какой-либо код(не уточняется вредоносный он или нет), скрытый при помощи этого метода. Но также они привели в презентации публичную модель, которую они нашли, которая хранит в себе код для выполнения команд в системе.

Помимо этого был представлен интересный инструмент, который сканирует модели на наличие подобных методов.

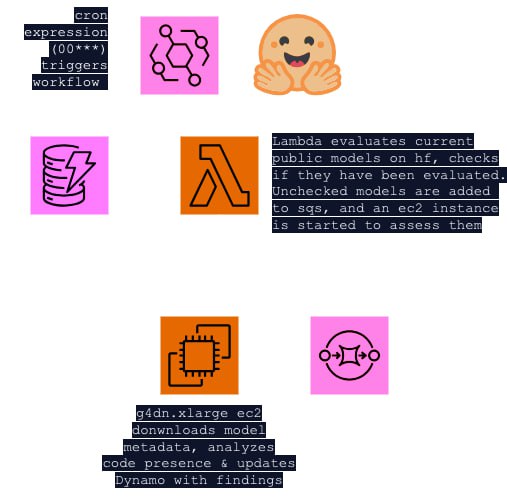

Он называется - bhakti. Этот инструмент предлагает набор скриптов, для анализа моделей(yara + python) + он может быть развёрнут для мониторинга моделей в AWS.

Я ознакомился с этим докладом. В докладе он представил ещё один способ выполнения вредоносного кода через модель, используя Keras Lambda layers. Раньше, он уже писал исследование на эту тему.(почитайте, это довольно интересный метод).

Какой метод был описан в докладе ? Если очень доступно, то в презентации был описан метод, когда злоумышленник, может хранить вредоносный код в lambda_layers, который расположен в файле keras_metadata.pb - этот файл получается в результате сериализации с использованием protobuf, и в дальнейшем он используется для работы модели.

Самое интересное. Они провели анализ 3000 моделей на huggingface, и нашли из них 24, которые содержали какой-либо код(не уточняется вредоносный он или нет), скрытый при помощи этого метода. Но также они привели в презентации публичную модель, которую они нашли, которая хранит в себе код для выполнения команд в системе.

Помимо этого был представлен интересный инструмент, который сканирует модели на наличие подобных методов.

Он называется - bhakti. Этот инструмент предлагает набор скриптов, для анализа моделей(yara + python) + он может быть развёрнут для мониторинга моделей в AWS.