Microsoft научила крошку-модель решать математику лучше, чем OpenAI o1

Новая статья от Microsoft доказала, что маленькие модельки могут в математику не хуже топовых гигантов. Все благодаря хитрому инференсу!

Самое интересное:

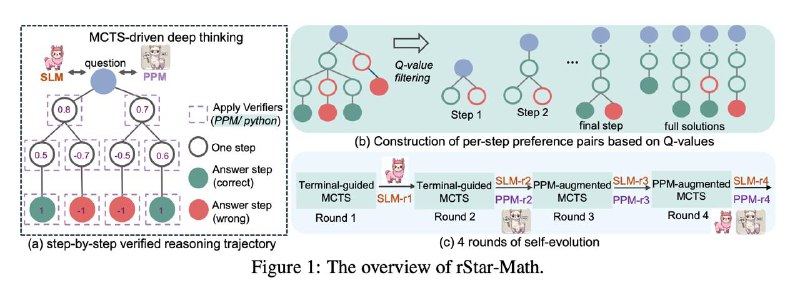

• Используется знакомый метод поиска по дереву решений Monte Carlo Tree Search

• Добавлен Code-augmented CoT для проверки шагов через код на питоне

• Введена попарная оценка ответов через Process Preference Model

• Применен итеративный self-evolution для обучения модели на своих же данных

На бенче MATH крошечная rStar-Math-7B выдала 89.4%, обогнав o1 на +4.5%. А на AIME 2024 показала 53.3%, что лучше o1 на +8.7%. И это все на модельке 7B!

Microsoft доказала, что размер не главное.

Пет-проект

Новая статья от Microsoft доказала, что маленькие модельки могут в математику не хуже топовых гигантов. Все благодаря хитрому инференсу!

Самое интересное:

• Используется знакомый метод поиска по дереву решений Monte Carlo Tree Search

• Добавлен Code-augmented CoT для проверки шагов через код на питоне

• Введена попарная оценка ответов через Process Preference Model

• Применен итеративный self-evolution для обучения модели на своих же данных

На бенче MATH крошечная rStar-Math-7B выдала 89.4%, обогнав o1 на +4.5%. А на AIME 2024 показала 53.3%, что лучше o1 на +8.7%. И это все на модельке 7B!

Microsoft доказала, что размер не главное.

Пет-проект