NVIDIA представила новое программное обеспечение (ПО) TensorRT-LLM для больших языковых моделей (LLM)

По мере развития LLM нужны результаты высокой точности для развертывания модели в производство. Более высокая производительность помогает улучшить взаимодействие с пользователем. Но увеличение размеров LLM приводит к увеличению затрат и сложности внедрения.

TensorRT-LLM — это библиотека с открытым исходным кодом, которая ускоряет и оптимизирует производительность вывода новых LLM на графических процессорах NVIDIA Tensor Core.

Библиотека объединяет компилятор глубокого обучения TensorRT, оптимизированные ядра FasterTransformer, предварительную и постобработку, а также взаимодействие между несколькими графическими процессорами и узлами в простой API Python для оптимизации и выполнения LLM при выводе в производство.

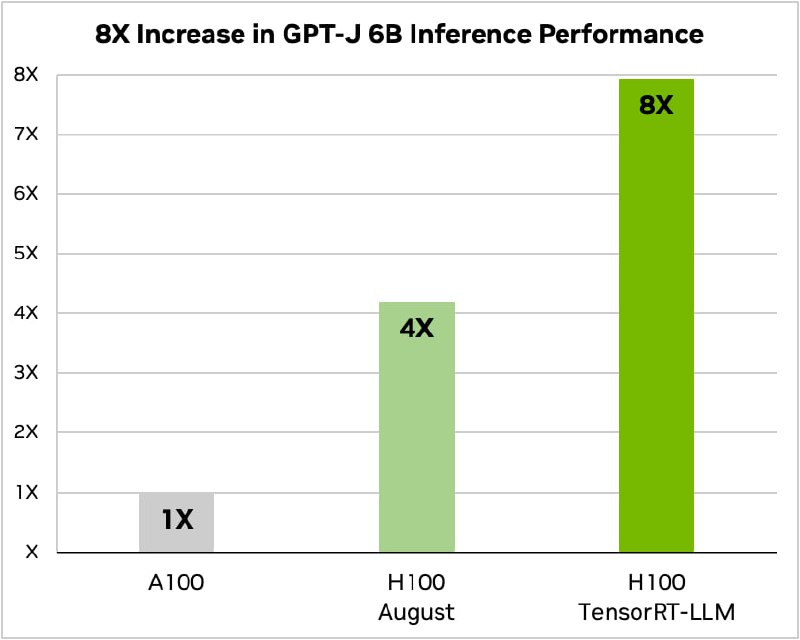

График показывает, что использование TensorRT-LLM для модели GPT-J-6B при суммаризации текстов приводит к увеличению производительности в 8 раз.

По мере развития LLM нужны результаты высокой точности для развертывания модели в производство. Более высокая производительность помогает улучшить взаимодействие с пользователем. Но увеличение размеров LLM приводит к увеличению затрат и сложности внедрения.

TensorRT-LLM — это библиотека с открытым исходным кодом, которая ускоряет и оптимизирует производительность вывода новых LLM на графических процессорах NVIDIA Tensor Core.

Библиотека объединяет компилятор глубокого обучения TensorRT, оптимизированные ядра FasterTransformer, предварительную и постобработку, а также взаимодействие между несколькими графическими процессорами и узлами в простой API Python для оптимизации и выполнения LLM при выводе в производство.

График показывает, что использование TensorRT-LLM для модели GPT-J-6B при суммаризации текстов приводит к увеличению производительности в 8 раз.