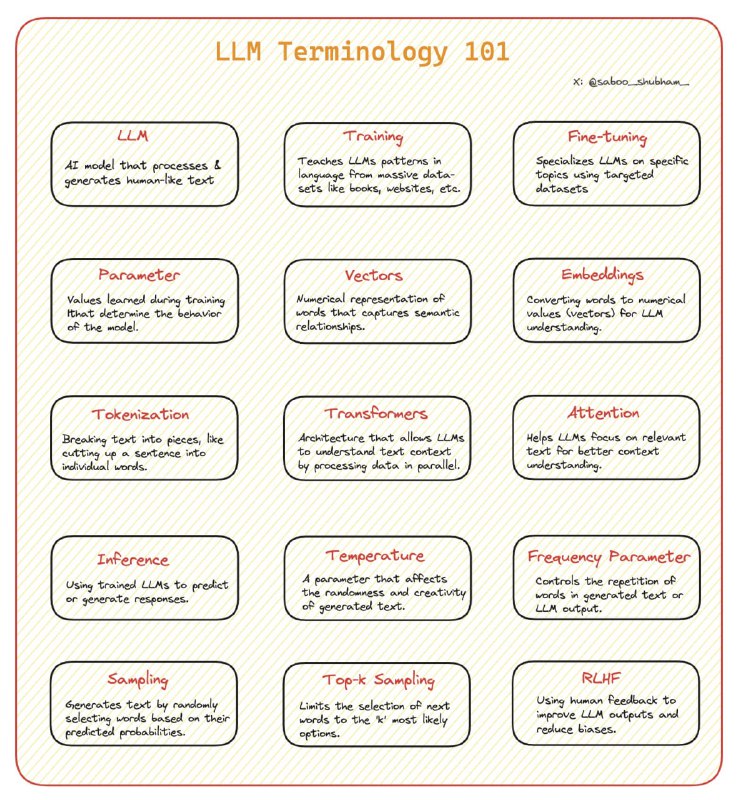

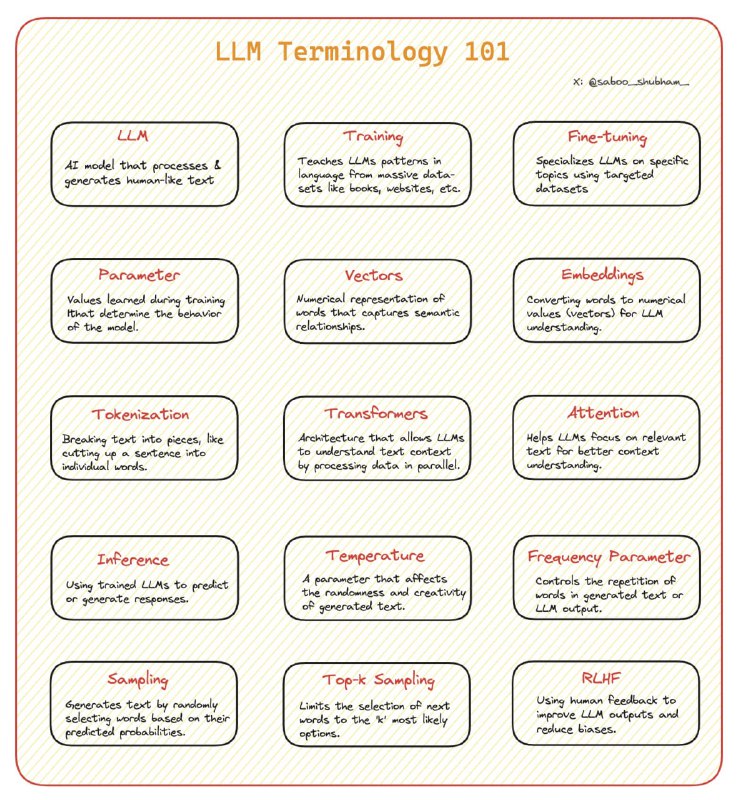

✍️ Терминология языковых моделей

Сегодня разбираемся с системой терминов, чтобы понимать, о чём говорят специалисты по ИИ.

🔘LLM (large language model) — большая языковая модель. К ним относятся GPT и другие подобные модели.

🔘Training (обучение) — процесс, во время которого языковая модель заучивает закономерности из текстов.

🔘Fine-tuning (часто так и говорят «файн-тюнинг» или тонкая настройка) — дообучение LLM для решения специфической задачи.

🔘Parameter (параметр) — элементы в модели (веса), которые определяют её поведение и обновляются в процессе обучения.

🔘Vectors (векторы) — числовое представление данных.

🔘Embeddings (как правило, не переводят, пишут как «эмбеддинги») — высокоразмерные векторы, которые представляют текст таким образом, чтобы сохранить семантическую близость.

🔘Tokenization (токенизация) — процесс разбиения текста на составляющие его части, или токены; является первым шагом предобработки данных для языковых моделей.

🔘Transformers (трансформеры) — архитектура, лежащая в основе многих LLM.

🔘Attention (внимание) — механизм, который помогает модели определять, какие части входного текста наиболее важны для текущей задачи.

🔘Inference (тоже обычно не переводят, пишут как «инференс») — использование обученной модели для генерации ответа.

🔘Temperature (температура) — установка значения температуры при инференсе позволяет управлять степенью случайности или разнообразия в ответе модели. Чем он выше, тем более непредсказуемым будет ответ.

🔘Frequency parameter (частота) — регулирует частоту появления определённых слов или фраз в генерируемом тексте.

🔘Sampling (сэмплинг) — метод выборки, используемый для генерации текста, позволяющий модели выбирать следующее слово из распределения вероятностей.

🔘Top-k sampling (топ-к сэмплинг) — стратегия генерации, при которой следующее слово выбирается только из k наиболее вероятных.

🔘RLHF (Reinforcement Learning from Human Feedback) — метод обучения моделей с использованием человеческих отзывов.