perplexity

Если описать простоты языком, perplexity (недоумение) – насколько хорошо модель предсказывает выборку.

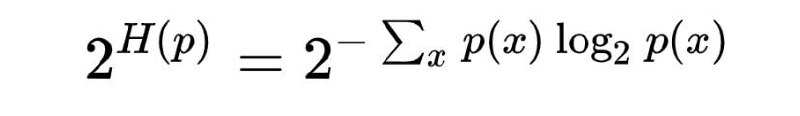

Если мы загуглим формулу PPL, то начнём формулу, показанную на первом рис. Вспоминая предыдущий пост, мы видим, что H(p), указанная в формуле ничто иное, как энтропия распределения(среднее количество битов, которое нужно для кодирования информации)

тогда PPL – это просто возведение в степень энтропии

Если энтропия – это среднее количество битов для кодирования, то возведение в степень энтропии должно представлять собой средневзвешенное количество вариантов выбора, которое имеет случайная величина

Если описать простоты языком, perplexity (недоумение) – насколько хорошо модель предсказывает выборку.

Если мы загуглим формулу PPL, то начнём формулу, показанную на первом рис. Вспоминая предыдущий пост, мы видим, что H(p), указанная в формуле ничто иное, как энтропия распределения(среднее количество битов, которое нужно для кодирования информации)

тогда PPL – это просто возведение в степень энтропии

Если энтропия – это среднее количество битов для кодирования, то возведение в степень энтропии должно представлять собой средневзвешенное количество вариантов выбора, которое имеет случайная величина