Энтропия Шеннона

Вид энтропии из которого вытекает функция потерь под названием Кросс-энтропия (https://t.me/nadlskom/15)

Чтобы начать понимать, что такое энтропия, надо начать мыслить в бинарном понимании (0 или 1). То есть положительный исход события - 1, отрицательный - 0

Если углубляться в это понимание, любую фразу мы можем закодировать в биты (8 бит * кол-во символов)

Опр. Энтропия переменной – это «количество информации», содержащееся в переменной.

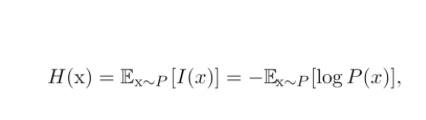

Обратимся к формуле и перепишем H, как ожидаемое значение исходной информации. (См. Рис) [**I(x)** – информация о содержании переменной **X**]

Если H(x) – общая информации о распределении вероятности, то 1/P(x) – информации о каждом отдельном случае.

Деление на 1/p в свою очередь показывает логику того, что имея множество равновероятных событий, зная, что одно из них свершилось, можно исключить вероятность этого события в остальных случаях

Вид энтропии из которого вытекает функция потерь под названием Кросс-энтропия (https://t.me/nadlskom/15)

Чтобы начать понимать, что такое энтропия, надо начать мыслить в бинарном понимании (0 или 1). То есть положительный исход события - 1, отрицательный - 0

Если углубляться в это понимание, любую фразу мы можем закодировать в биты (8 бит * кол-во символов)

Опр. Энтропия переменной – это «количество информации», содержащееся в переменной.

Обратимся к формуле и перепишем H, как ожидаемое значение исходной информации. (См. Рис) [**I(x)** – информация о содержании переменной **X**]

Если H(x) – общая информации о распределении вероятности, то 1/P(x) – информации о каждом отдельном случае.

Деление на 1/p в свою очередь показывает логику того, что имея множество равновероятных событий, зная, что одно из них свершилось, можно исключить вероятность этого события в остальных случаях