Самый полезный совет, который мог быть найден в этом канале: 🕺 если что-то не понимаешь, уходи на месяц от этого занятия, придешь, все быстро поймешь

У меня так было с этой статьей. Я ее мучала постоянными прочтениями, но не понимала, как это возможно. Сегодня к ней вернулась, и оказалось все очень легко. Сейчас расскажу.

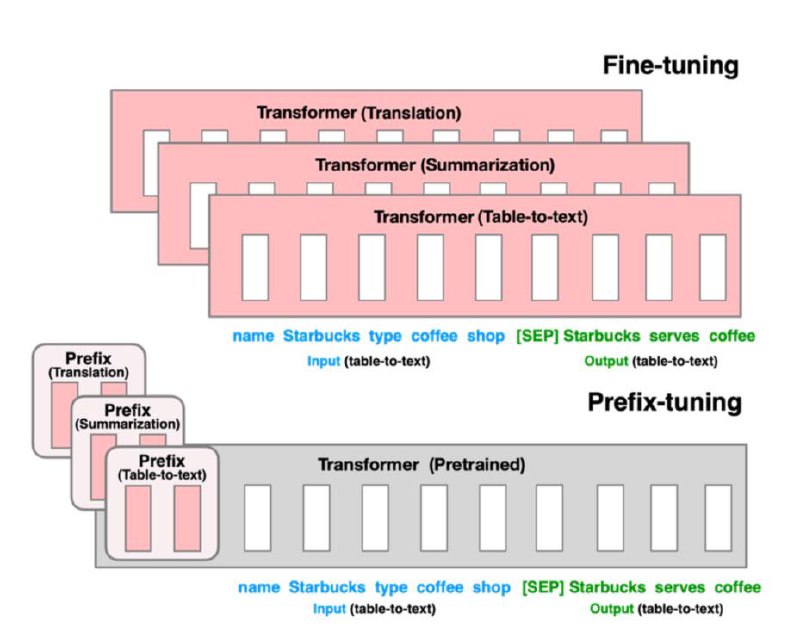

Prefix-tunning (2021) был третьим по хронологии выдоха PEFT методов, и основал обширную группу Soft prompts. Алгоритм следующий: давайте возьмем красивую идею заморозки предобученных весов от предшественников. Но вставлять будем обучаемые слои не как в адаптерах, а добавлять prefix, который и будем настраивать. То есть мы морозим слой эмбедингов, но оставляем не замороженным prefix

Все😐 . Помимо того, что мы уменьшаем количество параметров при ft, мы еще и можем делать «контролируемое обучение». Например, хочется обучить один префикс с определенным персонажем, а другой с другим. Получится модель, которая при активации одного из префиксов, говорит в определенной манере. Кажется, что фантазия для такого контролируемого обучения может быть безгранична. Дает большой потенциал к multitask 🌈

🖥 Код

#PEFT

У меня так было с этой статьей. Я ее мучала постоянными прочтениями, но не понимала, как это возможно. Сегодня к ней вернулась, и оказалось все очень легко. Сейчас расскажу.

Prefix-tunning (2021) был третьим по хронологии выдоха PEFT методов, и основал обширную группу Soft prompts. Алгоритм следующий: давайте возьмем красивую идею заморозки предобученных весов от предшественников. Но вставлять будем обучаемые слои не как в адаптерах, а добавлять prefix, который и будем настраивать. То есть мы морозим слой эмбедингов, но оставляем не замороженным prefix

Все

#PEFT