Mistral представили крутую языковую модель Mixtral 8x22B-v01.

Самое интересное о новинке:

— Нейронная сеть состоит из 8 экспертов, 2 из них активных;

— Использует 39B параметров из 141B, что обеспечивает высокую экономическую эффективность ;

— Контекст 64К (можно загружать документы и даже небольшие книги);

— Способна общаться на нескольких языках: английском, французском, немецком, испанском, итальянском и русском;

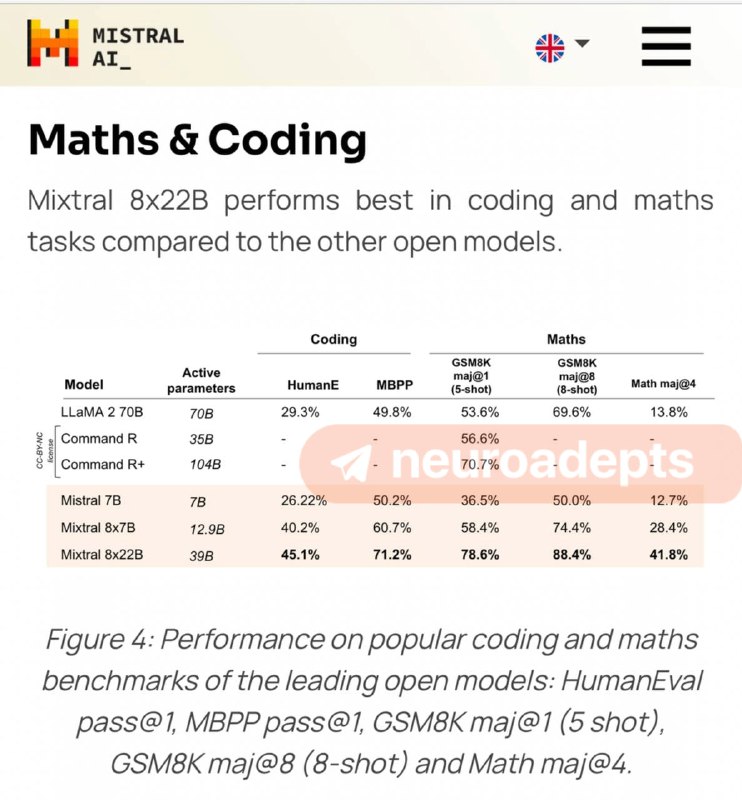

— Улучшенные математические навыки в области математики и кодирования;

— Присутствует цензура, но не такая строгая, как у некоторых других LLM.

➡️ Тестируем тут, читаем подробнее тут

INCUBEAI.Подписка

Самое интересное о новинке:

— Нейронная сеть состоит из 8 экспертов, 2 из них активных;

— Использует 39B параметров из 141B, что обеспечивает высокую экономическую эффективность ;

— Контекст 64К (можно загружать документы и даже небольшие книги);

— Способна общаться на нескольких языках: английском, французском, немецком, испанском, итальянском и русском;

— Улучшенные математические навыки в области математики и кодирования;

— Присутствует цензура, но не такая строгая, как у некоторых других LLM.

➡️ Тестируем тут, читаем подробнее тут

INCUBEAI.Подписка