🔥 Scalable Diffusion Models with Transformers

Вчера вышла интересная работа от ребят из UC Berkeley и NY University про комбинацию диффузии и трансформеров (Diffusion Transformers или DiT).

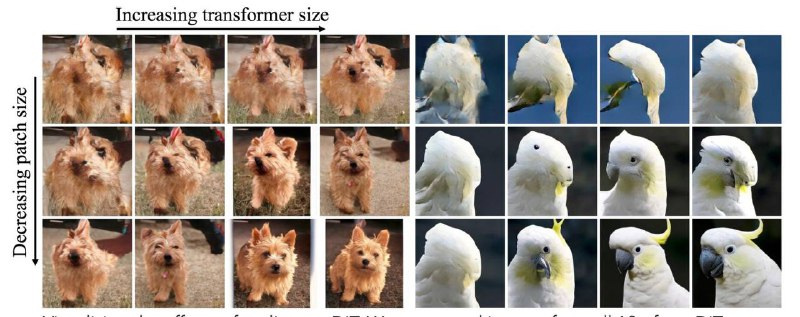

Ребята заменяют U-Net на трансформер и работают с патчами в латентном пространстве. DiT-XL/2 превосходит все class-conditional диффузионные модели на ImageNet 512x512 и 256x256 бенчмарках и достигает FID=2.27 для низкого разрешения. Более вычислительно тяжёлые DiT позволяют генерировать сэмплы очень высокого качества.

статья

гитхаб

колаб

Вчера вышла интересная работа от ребят из UC Berkeley и NY University про комбинацию диффузии и трансформеров (Diffusion Transformers или DiT).

Ребята заменяют U-Net на трансформер и работают с патчами в латентном пространстве. DiT-XL/2 превосходит все class-conditional диффузионные модели на ImageNet 512x512 и 256x256 бенчмарках и достигает FID=2.27 для низкого разрешения. Более вычислительно тяжёлые DiT позволяют генерировать сэмплы очень высокого качества.

статья

гитхаб

колаб