BetterTransformer

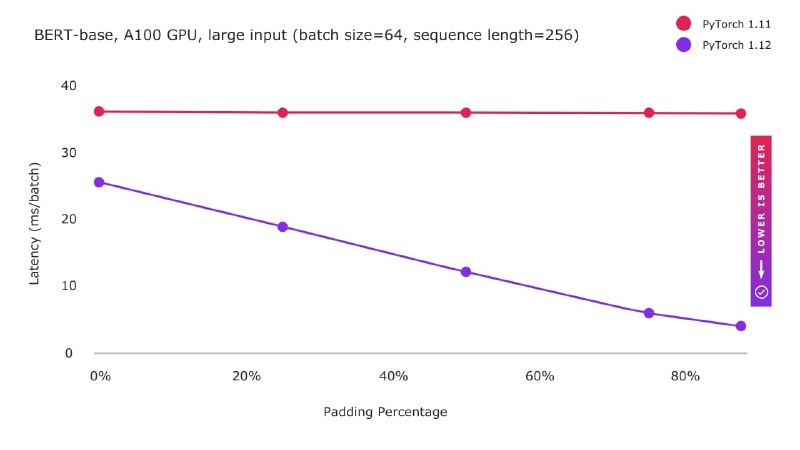

🔥 Ускорение инференса трансформеров в 2 раза из коробки

Совсем недавно PyTorch получил обновление 1.12, нам завезли

Разработчики интегрировали их в TorchText, причем для использования новой фичи не нужно переучивать или переделывать модели, достаточно указать один (!) параметр - enable_nested_tensor.

Фича работает как на GPU, так и на CPU.

В будущем добавят:

Кст, есть вроде как рабочий PR от разработчика из команды PyTorch в котором реализована работа для BERTа в HF.

@gradientdip

Блогпост

Колаб

Туториал

Issue

Pull Request

Nested Tensors

🔥 Ускорение инференса трансформеров в 2 раза из коробки

Совсем недавно PyTorch получил обновление 1.12, нам завезли

nested tensors, способные хранить в себе тензоры разного размера и через некотрое время после этого представили их использование в TransformerEncoder, а также MultiHeadAttention.Разработчики интегрировали их в TorchText, причем для использования новой фичи не нужно переучивать или переделывать модели, достаточно указать один (!) параметр - enable_nested_tensor.

Фича работает как на GPU, так и на CPU.

В будущем добавят:

TransformerDecoder для работы Seq2Seq моделей, использование новых тензоров для обучения и интеграцию в HuggingFace (!).Кст, есть вроде как рабочий PR от разработчика из команды PyTorch в котором реализована работа для BERTа в HF.

@gradientdip

Блогпост

Колаб

Туториал

Issue

Pull Request

Nested Tensors