Под постом про оптимизацию несколько раз спросили про байесовские методы. Раньше они у меня не заводились, но мыжтутучёные, штош, придётся пробовать. 🤓

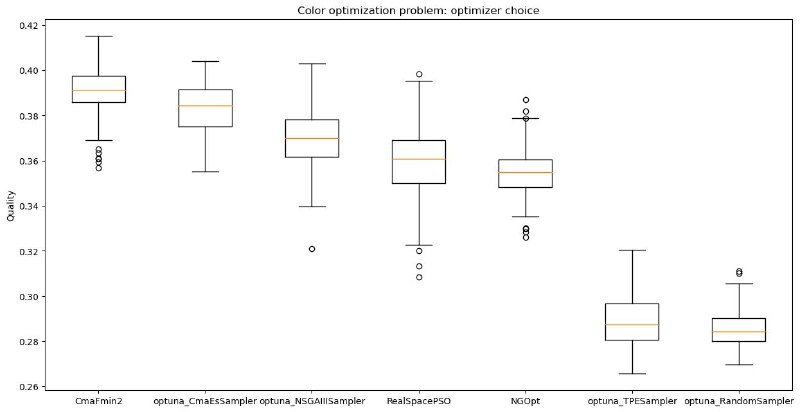

В качестве задачи я взял свой код для оптимизации цветовых палитр. Задача без тренировки дорогих сеток, но с большим количеством локальных минимумов и противной симметрией. Сравнил три популярных оптимайзера из Nevergrad с тремя из Оптуны, включая дефолтный TPE.

Результаты получились плохими для TPE, который оказался лишь капельку лучше случайного поиска.📉

Популяционные алгоритмы типа CMA оказались сильно лучше, да еще и сильно быстрее – примерно в 10 раз из-за того, что никакой умной оценки параметров не производится . Реализация из Nevergrad оказалась в ~1.5 раза быстрее своего аналога из оптуны.

В качестве задачи я взял свой код для оптимизации цветовых палитр. Задача без тренировки дорогих сеток, но с большим количеством локальных минимумов и противной симметрией. Сравнил три популярных оптимайзера из Nevergrad с тремя из Оптуны, включая дефолтный TPE.

Результаты получились плохими для TPE, который оказался лишь капельку лучше случайного поиска.

Популяционные алгоритмы типа CMA оказались сильно лучше, да еще и сильно быстрее – примерно в 10 раз из-за того, что никакой умной оценки параметров не производится . Реализация из Nevergrad оказалась в ~1.5 раза быстрее своего аналога из оптуны.