Пока я катался туда-сюда, у нас приняли ещё одну статью, на этот раз в TMLR. Называется “Tackling Provably Hard Representative Selection via Graph Neural Networks”.

Статья, на мой скромный вкус, интересная, потому что доказывает асимптотическую сложность проблемы выбора тренировочных данных для любого алгоритма.

Проблема супер жизненная – практически в лююой задаче нам нужно выбрать, на каких данных тренировать модель, причём в реальной жизни датасеты грязные.🦠 Например, для LLMок чистые данные помогают тренировать модели поменьше.

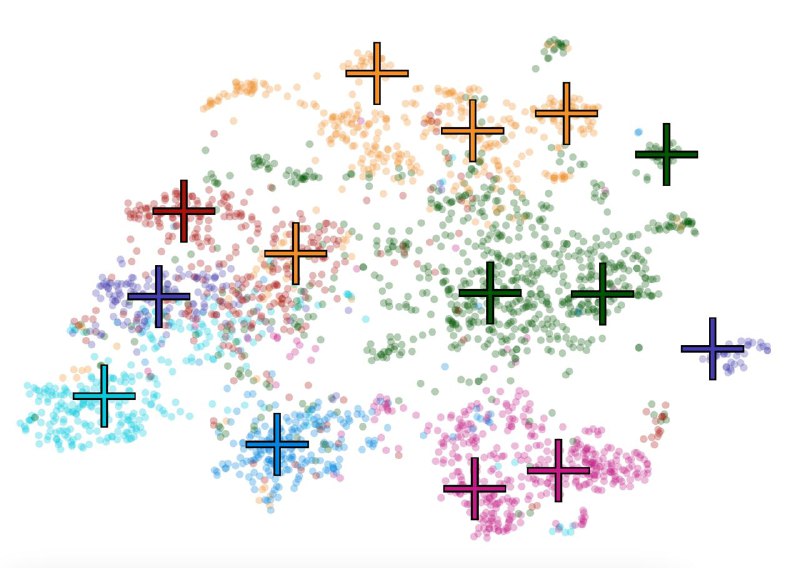

Доказанная в работе сложность – неподъёмная, так что приходится искать прокси-метрики для оптимизации. Мы предложили новый подход на основе графовых нейросетей, который очень сильно докидывает, когда у нас есть информация в виде структуры графа.🤴

В реальном мире, конечно, графы есть не везде, но и тут мы показываем, как бить сильные бейзланы: можно просто построить kNN граф и всё заработает.💁♂️

Статья, на мой скромный вкус, интересная, потому что доказывает асимптотическую сложность проблемы выбора тренировочных данных для любого алгоритма.

Проблема супер жизненная – практически в лююой задаче нам нужно выбрать, на каких данных тренировать модель, причём в реальной жизни датасеты грязные.

Доказанная в работе сложность – неподъёмная, так что приходится искать прокси-метрики для оптимизации. Мы предложили новый подход на основе графовых нейросетей, который очень сильно докидывает, когда у нас есть информация в виде структуры графа.

В реальном мире, конечно, графы есть не везде, но и тут мы показываем, как бить сильные бейзланы: можно просто построить kNN граф и всё заработает.