#articles #nlp

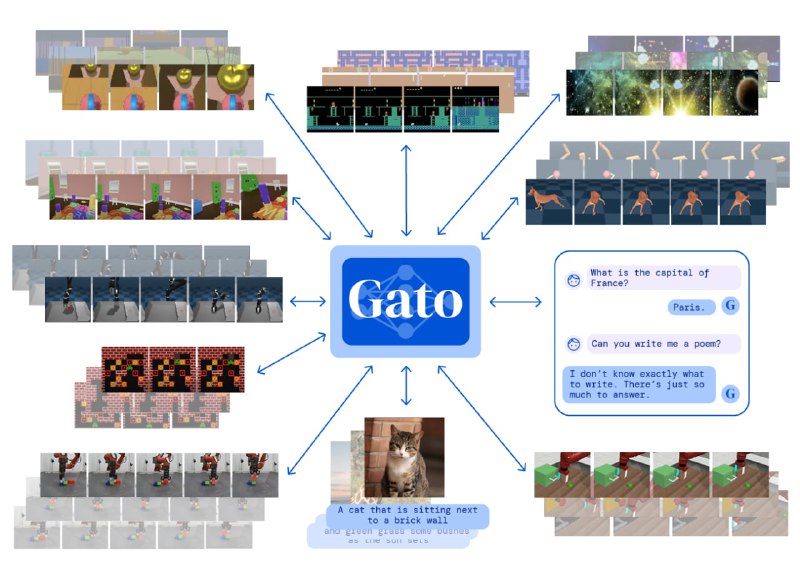

Gato — взгляд в сторону сильного ИИ

🧿 Вышла статья от DeepMind о том как они тренировали сеть решать мультимодальные задачи — играть в компьютерные игры, управлять роботом, а кроме этого расставлять подписи к картинкам и чатиться.

Вроде бы ничего особенного относительно SOTA результатов в каждой конкретной задаче, но суть на самом деле в следующем:

• Большая часть тренировочного датасета (85%) — это сценарии от игровых агентов.

• Остальная часть (15%) — это текстовые и графические данные, т.е данные другого типа нежели первые.

• В статье описываются эксперименты как претрейн на данных другой модальности влияет на обучение основного агента.

И вот это очень интересно, — во-первых, обучение на новых задачах может влечь Negative transfer (ухудшение качества в общем). Во-торых, возможен ли Positive transfer?

🧿 Если да, то значит сети можно обобщать (хорошо уметь делать все) и где-то вдалеке маячит возможность обучения того самого сильного ИИ, он же AGI (artificial general intelligence).

Статья

Gato — взгляд в сторону сильного ИИ

🧿 Вышла статья от DeepMind о том как они тренировали сеть решать мультимодальные задачи — играть в компьютерные игры, управлять роботом, а кроме этого расставлять подписи к картинкам и чатиться.

Вроде бы ничего особенного относительно SOTA результатов в каждой конкретной задаче, но суть на самом деле в следующем:

• Большая часть тренировочного датасета (85%) — это сценарии от игровых агентов.

• Остальная часть (15%) — это текстовые и графические данные, т.е данные другого типа нежели первые.

• В статье описываются эксперименты как претрейн на данных другой модальности влияет на обучение основного агента.

И вот это очень интересно, — во-первых, обучение на новых задачах может влечь Negative transfer (ухудшение качества в общем). Во-торых, возможен ли Positive transfer?

🧿 Если да, то значит сети можно обобщать (хорошо уметь делать все) и где-то вдалеке маячит возможность обучения того самого сильного ИИ, он же AGI (artificial general intelligence).

Статья