#чтивонаночь по быстрому

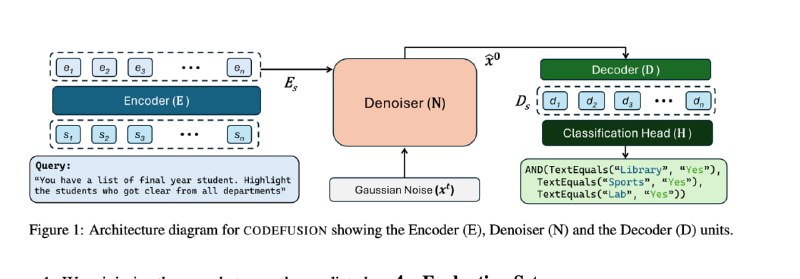

CODEFUSION: A Pre-trained Diffusion Model for Code Generation

и это прям умно - авторы берут претрен T5 еncoder, кидают его стейты в Denoiser(10 блоков трансформера - неизвестных) а в качестве декодера - 6 блоков декодера.

По метрика лучше чем соседи по классу, местами бьет 100кратно лучшие модели

а еще слили размер chatgpt, оказывается она всего то 20B. Имаджинируете лица людей которые разгоняли что у open ai в проде 175b?

paper

CODEFUSION: A Pre-trained Diffusion Model for Code Generation

и это прям умно - авторы берут претрен T5 еncoder, кидают его стейты в Denoiser(10 блоков трансформера - неизвестных) а в качестве декодера - 6 блоков декодера.

По метрика лучше чем соседи по классу, местами бьет 100кратно лучшие модели

а еще слили размер chatgpt, оказывается она всего то 20B. Имаджинируете лица людей которые разгоняли что у open ai в проде 175b?

paper