Boosting coherence of language models (by Microsoft)

Статья о том, как заставить уже обученные языковые модели лучше понимать дальний контекст.

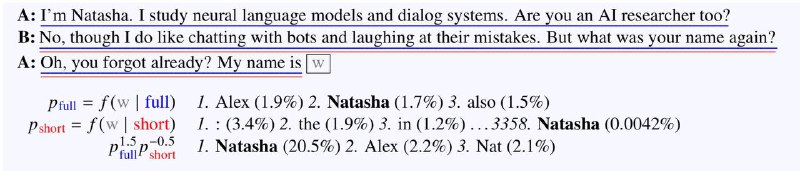

Идея простая, но удивительно эффективная — чтобы модель лучше понимала старый контекст, нужно уменьшить влияние нового. Для этого через модель прогоняют инпут дважды: сначала целиком, а потом только последние 3-10 слов получая два распределения вероятностей для следующего токена на основе полного и короткого контекстов (см. картинку). Затем первое распределение делят на второе и готово 💁♂️

Несмотря на простоту этого трюка, он даёт огромный прирост (~20%) на LAMBADA тесте, приближая возможности GPT-2 к GPT-3.

Статья, GitHub

Статья о том, как заставить уже обученные языковые модели лучше понимать дальний контекст.

Идея простая, но удивительно эффективная — чтобы модель лучше понимала старый контекст, нужно уменьшить влияние нового. Для этого через модель прогоняют инпут дважды: сначала целиком, а потом только последние 3-10 слов получая два распределения вероятностей для следующего токена на основе полного и короткого контекстов (см. картинку). Затем первое распределение делят на второе и готово 💁♂️

Несмотря на простоту этого трюка, он даёт огромный прирост (~20%) на LAMBADA тесте, приближая возможности GPT-2 к GPT-3.

Статья, GitHub