Как подружить GPT-3 с математикой

Языковые модели приблизились по своим возможностям к человеку, но у них всё ещё остались проблемы с multi-step reasoning и, особенно, с математикой.

В OpenAI предполагают, что дело в авторегрессионной генерации, ведь если модель чуть-чуть ошибётся в начале своих рассуждений, то и дальше всё пойдёт не так.

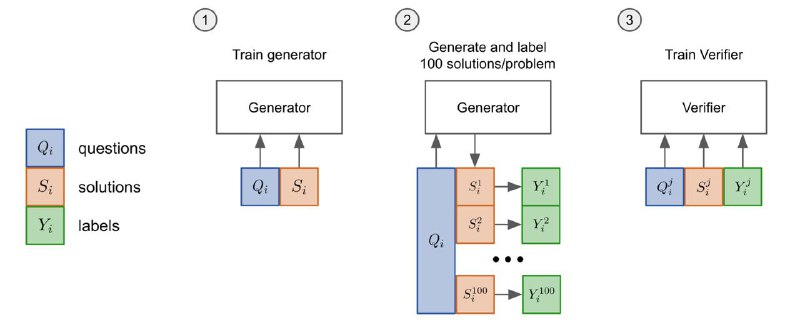

Как с этим бороться? Для начала, они создали датасет со школьными задачками и подробными текстовыми решениями. Затем они зафайнтюнили на этом две копии GPT-3: одна училась писать решение, а вторая — проверять правильное это решение или нет. Во время теста вторая модель выбирала лучшее решение из 100 сгенерированных.

Кроме этого, если в рассуждениях модели попадались формальные выражения, например «2+2=» то они автоматически вычислялись и заменялись на правильный ответ (да, это читерство 🤷♂️)

В итоге, получилось приблизиться к способностям живых школьников: 55% vs 60%.

Статья, blog, dataset

Языковые модели приблизились по своим возможностям к человеку, но у них всё ещё остались проблемы с multi-step reasoning и, особенно, с математикой.

В OpenAI предполагают, что дело в авторегрессионной генерации, ведь если модель чуть-чуть ошибётся в начале своих рассуждений, то и дальше всё пойдёт не так.

Как с этим бороться? Для начала, они создали датасет со школьными задачками и подробными текстовыми решениями. Затем они зафайнтюнили на этом две копии GPT-3: одна училась писать решение, а вторая — проверять правильное это решение или нет. Во время теста вторая модель выбирала лучшее решение из 100 сгенерированных.

Кроме этого, если в рассуждениях модели попадались формальные выражения, например «2+2=» то они автоматически вычислялись и заменялись на правильный ответ (да, это читерство 🤷♂️)

В итоге, получилось приблизиться к способностям живых школьников: 55% vs 60%.

Статья, blog, dataset