Real-World Adversarial Attack with Makeup

Можно ли обмануть системы распознавания лиц с помощью макияжа? На самом деле, это сложнее, чем кажется. Современные модели успешно игнорируют любые рисунки на лице и с лёгкостью идентифицируют вашу личность даже с липовой бородой и очками.

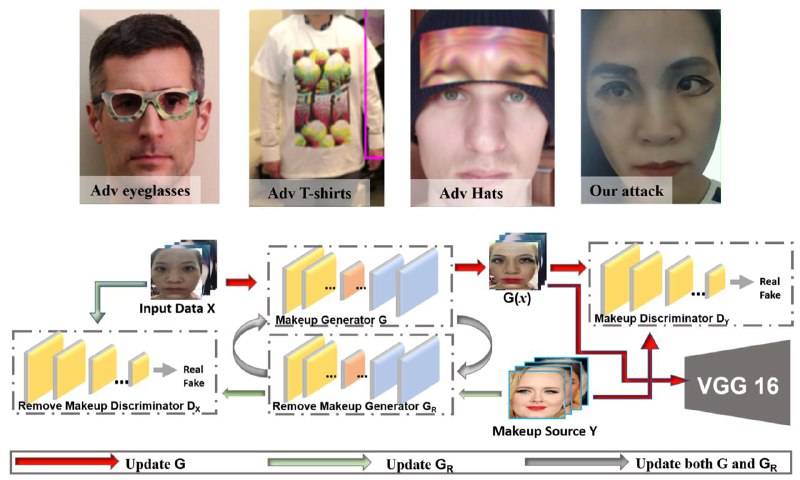

Ребята из IBM Watson Research Center предлагают генерировать специальный adversarial макияж с помощью Cycle-GAN (см. рисунок) и перерисовывать его на живого человека. Во время обучения они дополнительно накладывают Gaussian Blur, который немного «размазывает» рисунок, делая его более устойчивым к дальнейшим ошибкам и неточностям во время нанесения.

Таким образом, у них получилась targeted & untargeted white-box real-world атака на простенький классификатор (vgg16).

P.S. На картинке представлены и другие методы обмана surveillance систем: очки, футболка и шапка со сгенерированными adversarial рисунками

Статья

Можно ли обмануть системы распознавания лиц с помощью макияжа? На самом деле, это сложнее, чем кажется. Современные модели успешно игнорируют любые рисунки на лице и с лёгкостью идентифицируют вашу личность даже с липовой бородой и очками.

Ребята из IBM Watson Research Center предлагают генерировать специальный adversarial макияж с помощью Cycle-GAN (см. рисунок) и перерисовывать его на живого человека. Во время обучения они дополнительно накладывают Gaussian Blur, который немного «размазывает» рисунок, делая его более устойчивым к дальнейшим ошибкам и неточностям во время нанесения.

Таким образом, у них получилась targeted & untargeted white-box real-world атака на простенький классификатор (vgg16).

P.S. На картинке представлены и другие методы обмана surveillance систем: очки, футболка и шапка со сгенерированными adversarial рисунками

Статья