Attention Heads of LLM — A survey

Трансформеры это всё ещё чёрный ящик или уже нет? За последние несколько лет мы сильно приблизились к пониманию функций отдельных компонент языковых моделей, лучше понимаем, как они приходят к тому или иному выводу, и главное — как можно влиять на процес их "размышений", редактировать отдельные факты в памяти и многое другое.

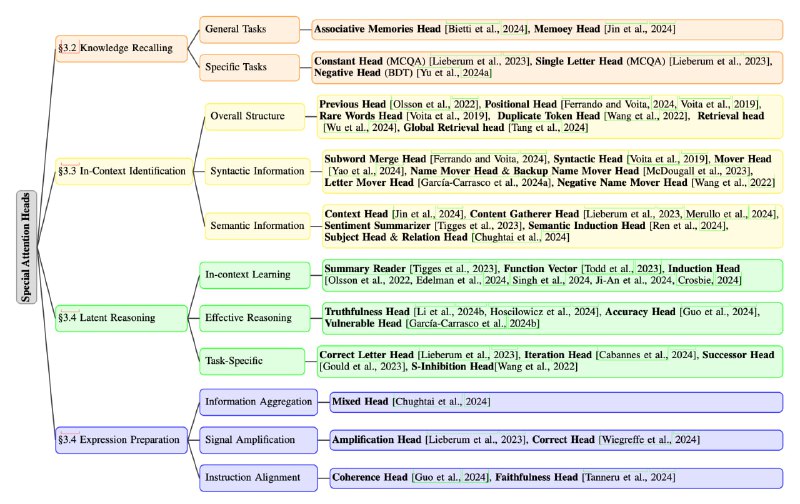

В этой статье собрали в кучку всё, что известно о функциях голов внимания в LLM с очень красивыми схемами и таблицами. Вот только небольшая часть:

- Associative Memories Head

- Truthfulness Head

- Semantic Induction Head

- Global Retrieval Head

- Subword Merge Head

Поэтому, если хотите погрузиться в интерпретируемость трансформеров — очень рекомендую полистать этот обзор.

Статья

Трансформеры это всё ещё чёрный ящик или уже нет? За последние несколько лет мы сильно приблизились к пониманию функций отдельных компонент языковых моделей, лучше понимаем, как они приходят к тому или иному выводу, и главное — как можно влиять на процес их "размышений", редактировать отдельные факты в памяти и многое другое.

В этой статье собрали в кучку всё, что известно о функциях голов внимания в LLM с очень красивыми схемами и таблицами. Вот только небольшая часть:

- Associative Memories Head

- Truthfulness Head

- Semantic Induction Head

- Global Retrieval Head

- Subword Merge Head

Поэтому, если хотите погрузиться в интерпретируемость трансформеров — очень рекомендую полистать этот обзор.

Статья