The Reversal Curse of LLM

Жаль, но похоже все языковые модели, независимо от размера, лажают на обобщениях фактов:

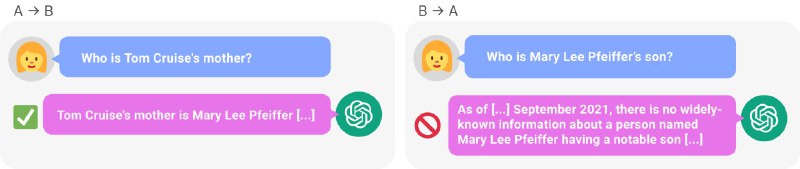

Авторы собрали несколько датасетов с такими логическими следствиями и проверили самые крутые модели (включая LlaMa и GPT-3). Оказалось, что обучаясь на факте "John is a son of Ann", модели не учат "Ann has a son John". А соответствующие логиты даже на капельку больше не становятся. Эта проблема есть и у GPT-4 (см. картинку).

Статья, GitHub

Жаль, но похоже все языковые модели, независимо от размера, лажают на обобщениях фактов:

A⠀is⠀B⠀→⠀B⠀is⠀A.Авторы собрали несколько датасетов с такими логическими следствиями и проверили самые крутые модели (включая LlaMa и GPT-3). Оказалось, что обучаясь на факте "John is a son of Ann", модели не учат "Ann has a son John". А соответствующие логиты даже на капельку больше не становятся. Эта проблема есть и у GPT-4 (см. картинку).

Статья, GitHub