Deep learning models might be secretly (almost) linear

Линейные модели обычно сильно ограничены в своих возможностях, поэтому в нейронки всегда добавляются слои активации (ReLU и тп).

Забавно, но существует много свидетельств, что нейронные сети на самом деле почти линейные (по инпуту и по весам). В этом блогпосте собрано 17 таких примеров со ссылками. Вот несколько самых интересных из них:

1. Веса моделей обученных от одной инициализации можно складывать (да, прям W1 + W2) и всё будет работать (тык, тык)

2. Ластик концептов позволяет удалять целые понятия из моделей одним линейным оператором (тык)

3. Работает линейная алгебра внутренних репрезентаций (тык)

4. Unsupervised linear probing (тык)

5. GPT микроскоп (colab)

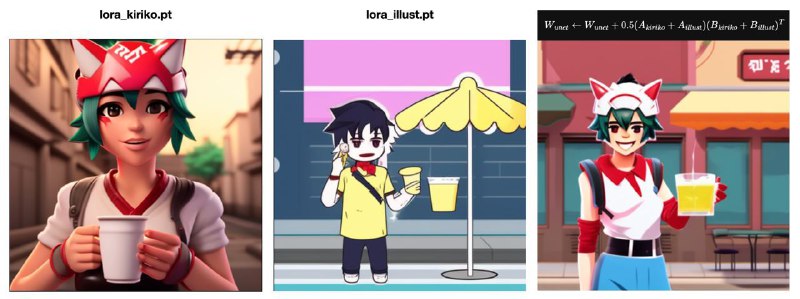

6. LoRa адаптеры линейно стыкуются (тык)

Похоже, что глубоким моделям достаточно совсем чуть-чуть нелинейности в поведении для получения потрясающих результатов.

Блогпост

Линейные модели обычно сильно ограничены в своих возможностях, поэтому в нейронки всегда добавляются слои активации (ReLU и тп).

Забавно, но существует много свидетельств, что нейронные сети на самом деле почти линейные (по инпуту и по весам). В этом блогпосте собрано 17 таких примеров со ссылками. Вот несколько самых интересных из них:

1. Веса моделей обученных от одной инициализации можно складывать (да, прям W1 + W2) и всё будет работать (тык, тык)

2. Ластик концептов позволяет удалять целые понятия из моделей одним линейным оператором (тык)

3. Работает линейная алгебра внутренних репрезентаций (тык)

4. Unsupervised linear probing (тык)

5. GPT микроскоп (colab)

6. LoRa адаптеры линейно стыкуются (тык)

Похоже, что глубоким моделям достаточно совсем чуть-чуть нелинейности в поведении для получения потрясающих результатов.

Блогпост