🔥MiniGPT-4: почти как GPT-4, но всего 13B параметров

Оказалось, если соединить LLaMA (Vicuna) и FROMAGe, то получится не только на 90% приблизиться к GPT-4, но и даже воспроизвести её визуальные навыки! При том, что тут обучается всего лишь один единственный линейный слой.

По сравнению с FROMAGe тут добавили Q-former и файнтюнинг на своём чистейшем визуально-диалоговом сете (3.5к примеров).

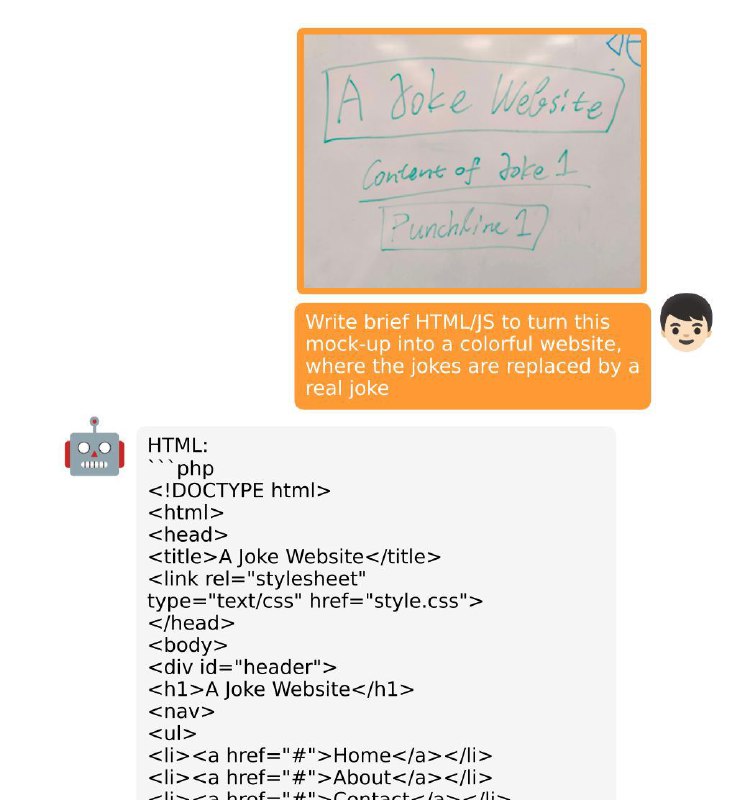

С помощью этой модели можно даже сгенерировать код сайта по одному лишь наброску! Код и веса есть в открытом доступе.

Статья, GitHub, датасет, блог

Оказалось, если соединить LLaMA (Vicuna) и FROMAGe, то получится не только на 90% приблизиться к GPT-4, но и даже воспроизвести её визуальные навыки! При том, что тут обучается всего лишь один единственный линейный слой.

По сравнению с FROMAGe тут добавили Q-former и файнтюнинг на своём чистейшем визуально-диалоговом сете (3.5к примеров).

С помощью этой модели можно даже сгенерировать код сайта по одному лишь наброску! Код и веса есть в открытом доступе.

Статья, GitHub, датасет, блог