Language Modeling with Pixels

А что будет, если учить нейронную сеть понимать текст по скриншотам? Оказалось, что такая модель будет работать ничуть не хуже, чем BERT, и, к тому же, ещё и понимать мультсимвольный шифр:

ᗪ🝗🝗尸 ㇄🝗闩尺𝓝讠𝓝Ꮆ.

Авторы предложили вместо дискретных токенов предсказывать пиксели буквенных символов. Подход очень похож на смесь BERT и ViT-MAE — сначала обучающие тексты рендерятся в изображение, а затем маскируются и восстанавливаются разные его куски. Этот подход позволил избавиться от так называемого vocabulary bottleneck — то есть нет необходимости хранить огромное количество эмбеддингов для десятков тысяч токенов и вычислять дорогостоящий софтмакс.

В итоге, модель демонстрирует сравнимый с бертом перформанс и гораздо более устойчива к adversarial атакам.

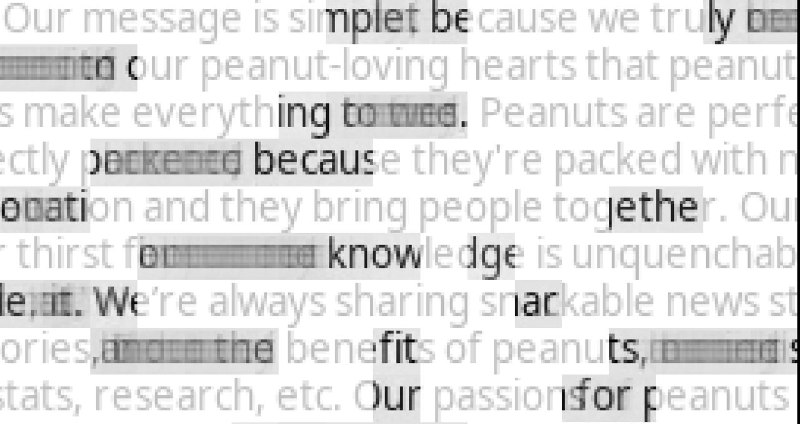

P.S. На картинке показана работа промежуточного чекпоинта модели, когда она научилась декодить замаскированный текст, но ещё не до конца.

Статья, GitHub, Hugging Face

А что будет, если учить нейронную сеть понимать текст по скриншотам? Оказалось, что такая модель будет работать ничуть не хуже, чем BERT, и, к тому же, ещё и понимать мультсимвольный шифр:

ᗪ🝗🝗尸 ㇄🝗闩尺𝓝讠𝓝Ꮆ.

Авторы предложили вместо дискретных токенов предсказывать пиксели буквенных символов. Подход очень похож на смесь BERT и ViT-MAE — сначала обучающие тексты рендерятся в изображение, а затем маскируются и восстанавливаются разные его куски. Этот подход позволил избавиться от так называемого vocabulary bottleneck — то есть нет необходимости хранить огромное количество эмбеддингов для десятков тысяч токенов и вычислять дорогостоящий софтмакс.

В итоге, модель демонстрирует сравнимый с бертом перформанс и гораздо более устойчива к adversarial атакам.

P.S. На картинке показана работа промежуточного чекпоинта модели, когда она научилась декодить замаскированный текст, но ещё не до конца.

Статья, GitHub, Hugging Face