GPT-3 умеет в ML!

Кто-то до сих пор считает, что все эти языковые модели умеют только запоминать и воспроизводить увиденное во время обучения?

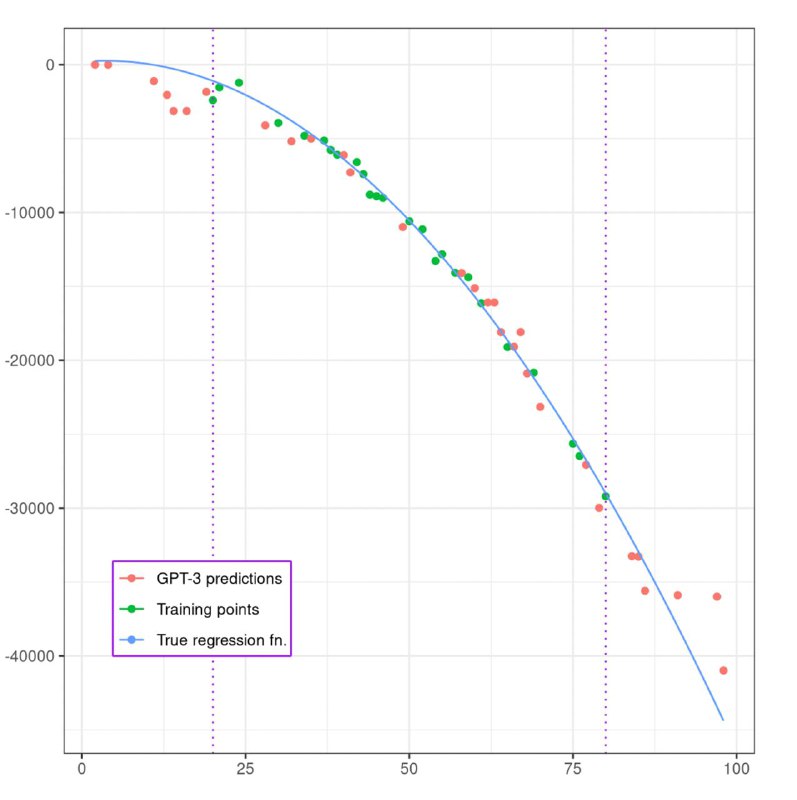

Рад вас расстроить — они умеют гораздо больше! Тут попробовали во few-shot режиме скормить GPT-3 данные из Iris датасета, и она очень неплохо справилась — точность 95%! А ещё, она умеет в нелинейную регрессию (см. картинку).

Всё-таки языковые модели могут находить за токенами скрытый смысл 💁♂️

Блог, GitHub

Кто-то до сих пор считает, что все эти языковые модели умеют только запоминать и воспроизводить увиденное во время обучения?

Рад вас расстроить — они умеют гораздо больше! Тут попробовали во few-shot режиме скормить GPT-3 данные из Iris датасета, и она очень неплохо справилась — точность 95%! А ещё, она умеет в нелинейную регрессию (см. картинку).

Всё-таки языковые модели могут находить за токенами скрытый смысл 💁♂️

Блог, GitHub