Flamingo: a Visual Language Model (by DeepMind)

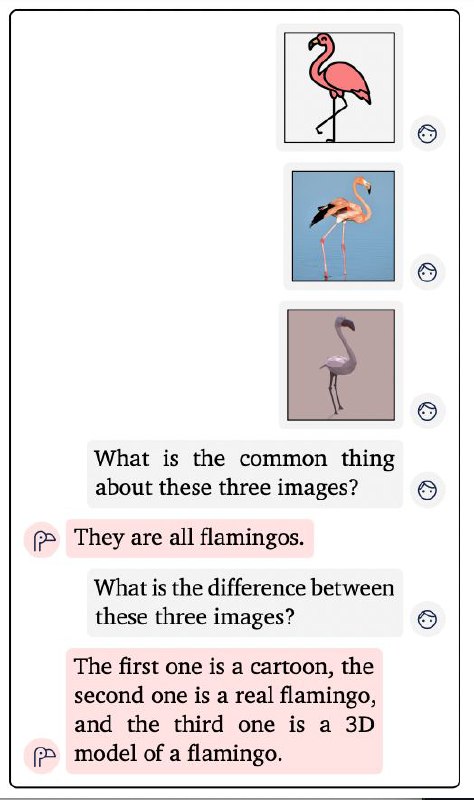

На мой взгляд, это самая многообещающая работа за последнее время. Авторы представили модель, которая способна понимать смесь картинок и текста. Это позволяет решать кучу новых задач во few-shot режиме и даже вести визуальный диалог (см. картинку).

Идея довольно оригинальная — авторы предлагают вставить внутрь замороженной языковой модели (Chinchilla) дополнительные gated cross-attention блоки, которые будут показывать ей фичи от предобученного и замороженного визуального энкодера. А обучаются здесь ТОЛЬКО эти новые cross-attention блоки. В итоге получается языковая модель, с дополнительным вниманием на визуальные фичи картинок, вставленных в текст.

Для обучения собрали новый датасет — MultiModal MassiveWeb (M3W), состоящий из 43М веб-страниц, где картинки и текст идут вперемешку, а ещё к нему подмешивают датасет ALIGN.

Статья, GitHub

На мой взгляд, это самая многообещающая работа за последнее время. Авторы представили модель, которая способна понимать смесь картинок и текста. Это позволяет решать кучу новых задач во few-shot режиме и даже вести визуальный диалог (см. картинку).

Идея довольно оригинальная — авторы предлагают вставить внутрь замороженной языковой модели (Chinchilla) дополнительные gated cross-attention блоки, которые будут показывать ей фичи от предобученного и замороженного визуального энкодера. А обучаются здесь ТОЛЬКО эти новые cross-attention блоки. В итоге получается языковая модель, с дополнительным вниманием на визуальные фичи картинок, вставленных в текст.

Для обучения собрали новый датасет — MultiModal MassiveWeb (M3W), состоящий из 43М веб-страниц, где картинки и текст идут вперемешку, а ещё к нему подмешивают датасет ALIGN.

Статья, GitHub